Demokratie bedeutet Volksherrschaft, nicht Parteienherrschaft.

Das EXXON-#Verwirrspiel des Stefan @Rahmstorf (V1) von www.klimamanifest.ch

Die Lügengeschichten des Stefan Rahmsdorf

Vortrag-Klimahysterie-Strahlenhysterie-EIKE-Tagung-2019

Dr. Lutz Niemann, 13. Internationale Klima- und Energiekonferenz, 22.-23.11.2019, München

Ich habe Physik studiert und habe bei meiner Diplomarbeit und Dissertation mit offenen radioaktiven Stoffen gearbeitet. Daher hatte ich seit meinem Studium Kenntnisse im Umgang mit Radioaktivität, ich kannte schon immer die Bedeutung von Becquerel und Milli-Sievert.

Im Beruf habe ich bei Siemens zum Thema „elektrische Kontakte“ gearbeitet, war dort Strahlenschutzbeauftrag- ter für Vollschutzgeräte, wurde fortgebildet. Das Interesse für Strahlenthemen blieb erhalten, daher stehe ich jetzt hier. Zunächst wenige Worte zur Klimahysterie: Auch ich habe lange Zeit den Zusammenhang von CO2 und Klima für richtig gehalten, ich bin auf die einfachen Modellvorstellungen und Deutungen herein gefallen. Erst das EIKE-Buch von Michael Limburg „Klimahysterie“ brachte den für mich den entscheidenden Hinweis:

Es sind in der Luft in jedem beliebigen Volumen viel mehr H2O-Moleküle als CO2-Moleküle enthalten. H2O und CO2 sind beides Moleküle mit einem Dipolmoment, sind daher IR-aktiv, und daher kommt es auf die Anzahl der Moleküle in einem Volumen Luft an. Bei 20°C und 60% Feuchte sind zum Beispiel 55-mal mehr Moleküle von H2O vorhanden als von CO2.

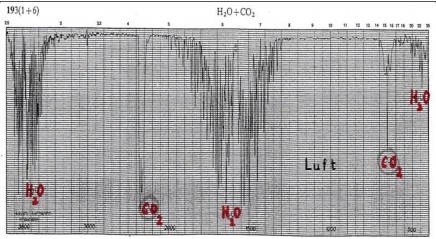

Ich habe bei Siemens in München in der Hofmannstraße das Infrarot-Spektrometer betreut. Dabei muß vor je- der Analyse der Untergrund aufgenommen werden, das ist die Infrarotanalyse der 10 cm Luftstrecke im Strah- lengang des Gerätes, das zeigt Bild 1. H2O hat viel mehr Absorptionsbanden als CO2.

Bild 1: Infrarot-Spektrum von Luft, Untergrund bei der IR-Analyse

Bild 2: Infrarot-Spektrum von Luft aus der IR- Bibliothek

Dasselbe erkennt man auch beim Infrarot-Spektrum von Luft, wie es in jeder Spektrumbibliothek enthalten ist, siehe Bild 2.

Diese Darstellungen zeigen: Es hat H2O (Wasser) eine viel größere Wirkung als CO2 auf alle Vorgänge infolge Strah- lungsabsorption in der Atmosphäre, es wirkt über einen viel größeren Wellenlängenbereich und die integrale Fläche der Peaks ist größer.

CO2 hat nur eine Wirkung von wenigen %, wenn es um die Strahlenabsorption in der Luft geht. H2O ist be- stimmend in der Atmosphäre und bestimmt das Wetter und damit die Klimate an allen Stellen der Erde. Der Wasserkreislauf spielt die Hauptrolle bei Wetter und Klima, dabei insbesondere die latente Wärme, die bei des- sen Phasenübergängen gebunden oder freigesetzt wird. Daher gilt:

Wer CO2 sagt, ist schon auf die Demagogie herein gefallen, denn der Wasserkreislauf bestimmt das Wetter und damit alle Klimate an allen Stellen der Erde, dabei wird alles gesteuert von der Sonne. CO2 hat keinen Einfluß auf die Wettervorgänge in der Atmosphäre. [1]

Zur Strahlenhysterie: Der Unfall in Fukushima 2011

Vorweg wenige Worte zur Wissenschaftlichkeit der Arbeit von EIKE: Seit dem März 2011 habe ich 37 Berichte geschrieben, alle wurden bei EIKE veröffentlicht. 7 dieser Berichte wurden in Fachzeitschriften abgedruckt, das waren die „StrahlenschutzPRAXIS“ und das „Internat. Jour. f. Nuclear Power“. Beides sind private wissenschaft- liche Zeitschriften jeweils eines Vereins für seine eigenen Mitglieder: vom „Fachverband Strahlenschutz Deutschland – Schweiz“ (FS) und von der „Kerntechnischen Gesellschaft“. Mit dem Abdruck meiner Berichte erhalten meine Berichte die Zustimmung der wissenschaftlichen Fachwelt.

Beim Erdbeben am 11.3.2011 wurden alle Reaktoren in Fukushima bestimmungsgemäß automatisch abge- schaltet und die Kerne weiter gekühlt. Erst durch den Tsunami etwa eine ¾-tel Stunde später wurde das Kraft- werksgelände überflutet und die Stromversorgung fiel aus, weil sich Schalträume und Notstromversorgung im Keller befanden. Damit gab es für die Reaktoren keine Kühlung mehr. Es stiegen Temperatur und Druck in den Reaktordruckgefäßen, so daß bald Druck abgelassen werden mußte. Als der Wasserspiegel in den Reaktoren gesunken war und Brennelemente nicht mehr gekühlt wurden, konnte bei der gestiegenen Temperatur durch Reaktion von Zr mit H2O Wasserstoff entstehen, der bei den notwendigen Druckentlastungen frei gesetzt wur- de. Es gab mehrere Wasserstoffexplosionen, wobei Gebäude zerstört wurden, nicht jedoch der Reaktor. Dabei wurden radioaktive Spaltprodukte frei gesetzt.

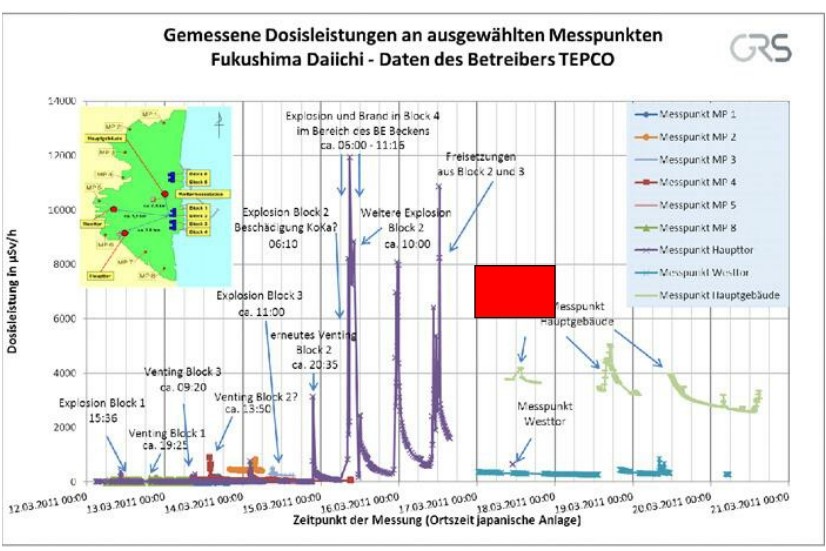

In den automatischen Meßstellen auf dem Kraftwerksgelände wurde die Ortsdosisleistung der Strahlung ge- messen, die Daten waren weltweit abrufbar. Hier eines der Diagramme. In Deutschland haben die Kollegen der GRS eine erläuternde Beschriftung in die Diagramme eingefügt, siehe Bild 3.

Bild 3: Ortsdosisleistung auf dem Kraftwerksgelände von Fukushima [2]

Über der Zeitachse ist die Ortsdosisleistung an den verschiedenen Meßpunkten auf dem Kraftwerksgelände aufgetragen. Die Peaks bedeuten immer ein Freisetzen von Radioaktivität in die Luft.

Das rote Feld bedeutet eine kumulierte Strahlendosis von 48 Milli-Sievert innerhalb von 24 Stunden. Diese Do- sis kann erreicht werden, wenn sich eine Person 24 Stunden am Ort des Meßpunktes auf dem Kraftwerksge- ländes aufhält. Nun sind 48 Milli-Sievert ein Hundertstel der letalen Dosis von 5 Sievert, wo es gefährlich wird. Die Dosis 5 Sievert führt zur Strahlenkrankheit, wobei 50% der Menschen an der Strahlenkrankheit sterben.

Mit diesem Diagramm wird klar: Niemand innerhalb und außerhalb des Kraftwerksgeländes konnte eine für die Gesundheit gefährliche Strahlendosis erhalten. Und in den Kraftwerksgebäuden gibt es nur ausgebildete Personen, die wegen ihrer Meßgeräte Gefahrenstellen meiden konnten. Damit war klar, daß es durch den Un- fall keine Gefährdung von Menschen durch die frei gesetzte Radioaktivität geben konnte.

Das wurde bestätigt durch Mitarbeiter der IAEA (Wiener Atomenergie-behörde), die im Mai 2011 nach Japan gereist sind und dort gemessen haben. Es wird durch den Unfall keine gesundheitlichen Schädigungen von Personen durch frei gesetzte Radioaktivität geben, so hieß es in einem vorläufigen Bericht der IAEA vom

1.6.2011. Auf der EIKE-Seite wurde eine Zusammenfassung des Berichtes von mir Anfang Juni 2011 eingestellt und ist dort abrufbar.

In deutschen Medien war nichts von den aufschlußreichen täglichen Veröffentlichungen der Strahlungsmessun- gen in Fukushima zu finden. Nur im Münchner Merkur war einmal ein Diagramm wie Bild 3 zu finden, Herrn Dirk Ippen sei Dank dafür.

Die Strahlenschutzgesetze verlangen nun, daß auch vor Strahlung zu schützen ist, die KEINE Gefährdung der Menschen zur Folge haben kann. Daher wurde schon am 11. März damit begonnen, die Bevölkerung in der Umgebung des Kraftwerkes zu evakuieren. Über 100 000 Menschen wurden insgesamt aus ihren Häusern vertrieben oder gingen aus Strahlenangst auch freiwillig. Viele mussten lange Zeit in Massenunterkünften leben, was für die Betroffenen eine Katastrophe bedeutete. In der deutschen Fachzeitschrift StrahlenschutzPRAXIS heißt es dazu:

Fukushima war keine radiologische Katastrophe, sondern es war eine soziale Katastrophe.

Nicht die Strahlung führte in Japan zu gesundheitlichen Problemen, sondern die Evakuierungen führten zu Problemen und auch zu sehr vielen Todesfällen.

Es wurden die Krankenhäuser und Altenheime evakuiert, mit schlimmen Folgen für die betroffenen Menschen. Nach anfänglichem Zögern wurden sogar die Intensivpatienten aus den Krankenhäusern abtransportiert, mit unmittelbar tödlichen Folgen für rund 50 Patienten. Das ist durch Gesetz verordneter Totschlag.

Die aus Altenheimen abtransportierten Patienten wurden in andere Heime verlegt. Da aber dazu Platz fehlte, wurden sie oft umeinander gekarrt, von einem Ort zum nächsten Ort. Die Sterblichkeit der alten Leute stieg auf das 4-fache an, siehe Bild 4.

Bild 4: Anstieg der Todesfälle in Altersheimen um 300% durch die Evakuierungen [3]

In allgemein zugänglichen Medien herrscht Schweigen zu den sozialen Folgen von Fukushima. Nur in SPIEGEL wurde von 150 bis 600 Todesopfern durch die Evakuierungen berichtet. In der Fachzeitschrift Strahlenschutz- PRAXIS berichten Michel, Völkle und Lorenz:

Der Fukushima-Unfall brachte keine Schädigungen der Menschen durch die Strahlung, aber die Evakuierungen hatten mehr als 1000 tödliche Strahlenschutzopfer zur Folge.

Diese Zahl aus dem Kreise der Fachleute dürfte der Wahrheit am nächsten kommen: Die Menschen wurden per Gesetz vor Strahlung geschützt, und dieser Schutz führte für viele zum Tod.

Viel wichtiger als der Strahlenschutz wäre daher ein Schutz vor den Strahlenschützern.

Als Beleg einige Beispiele zu den Folgen der unsinnigen Strahlenschutzgesetzgebung: Beispiel 1:

Bild 5: Strahlendosis durch freigesetzte Radioaktivität, Summe bis März 2012, [2]

Die freigesetzte Radioaktivität verursachte in der Umgebung von Fukushima eine Bodenkontamination. Es wur- den in Fachmedien sowohl die Verteilung der Bodenkontamination wie auch der Dosis für Menschen darge- stellt. Bild 5 zeigt die aufsummierte Dosis im ersten Jahr nach dem Unfall für Personen, wenn sie sich das gan- ze Jahr dort im Freien aufhalten würden. Der Mensch lebt jedoch überwiegend in Häusern, daher ist es vernünf- tig, die in Bild 5 angegebenen Dosen durch 10 zu dividieren, um zu realen Dosiswerten für die Bevölkerung zu gelangen.

Um die Bedeutung einer Dosis von 20 bzw. 2 Milli-Sievert einzuschätzen ist ein Vergleich notwendig. Dazu soll die zusätzliche Strahlendosis beim Fliegen dienen. Auf unserer Breite hat man in Reiseflughöhe von 12km ei- nen Strahlenpegel – das ist die Dosis pro Zeiteinheit, also die Ortsdosisleistung – der rund das 100-fache von derjenigen unten am Boden beträgt. Die Strahlung ist mit der Aktivität der Sonne variabel und vom Breitengrad abhängig. Beim fliegenden Personal der Lufthansa summiert sich die Strahlendosis in einem Jahr auf maximal rund 10 mSv, wenn es überwiegend die Nordatlantikroute fliegt. Der Mittelwert der Zusatzdosis vom gesamten Lufthansapersonal liegt bei 2 mSv. Diese zusätzlichen Bestrahlungsdosen werden jedes Jahr veröffentlicht. Es wurden also in Japan Menschen wegen einer Dosis evakuiert, die beim Lufthansaperso- nal erlaubt ist, nur spricht man bei Lufthansapersonal und den Passagieren im Flieger nicht von „Verstrahlung“. Bild 6 zeigt ein Beispiel der Flugzeuge über dem Nordatlantik zwischen USA und Europa.

Bild 6: Flugradar vom 30.8.2019 um 7:50 Uhr MEZ. [5]

In jedem dieser Flugzeuge sitzen 100 oder 200 oder mehr Menschen und werden „verstrahlt“. Bei ihnen ist die „Verstrahlung“ erlaubt, nicht jedoch in Fukushima, daher wurden die Menschen evakuiert.

Beispiel 2: In Deutschland wurden unter der damaligen Bundesministerin Frau Ilse Aigner die Grenzwerte für Lebensmit- telkontamination herab gesetzt auf 600 Bq/kg durch Cs-137. Noch heute muß immer wieder Wildschweinfleisch entsorgt werden, das vom Tschernobyl-Unfall kontaminiert wurde. Die Rechnung zeigt: Wer derart kontaminier- tes Fleisch von Wild verspeist, erhält durch verspeiste 100 Bq Cs-137 eine Zusatzdosis von 0,0014 mSv. Diese Zusatzdosis ist identisch mit der Zusatzdosis von 15 Minuten Flug auf unserer Breite in Reiseflughöhe. Die Be- grenzung der Lebensmittelkontamination ist unsinnig, denn bei einer Flugreise werden viel höhere Strahlendosen erreicht. Die Herabsetzung der Grenzwerte war politisch bedingt, sie erzeugt unbegrün- dete Strahlenangst. Seit Frau Aigner Ministerin wurde, ist sie für mich als Bürger unerreichbar, Briefe werden von ihrem Büropersonal mit „Danke“ plus den üblichen nichts sagenden Sätzen beantwortet.

Beispiel 3: In Japan hat man sehr strenge Vorgaben beim Strahlenschutz: Es wurden weite Gebiete rund um das Kraftwerk dekontaminiert, d.h. die oberen 10cm Boden abgetragen. Dieser Boden steht dort jetzt in riesigen Säcken ein- gefüllt in der Landschaft, es sind etwa 30 Millionen Kubikmeter. Ziel dieser Maßnahme war es, die Ortsdosis- leistung auf 0,0001 bis 0,0002 mSv pro Stunde herab zu drücken. Im Flugzeug bei uns und desgleichen in Japan auf Reiseflughöhe hat man rund 0,006 mSv/h oder noch mehr, also einen zig-fach höheren Strah- lenpegel, mit dem die Passagiere „verstrahlt“ werden dürfen. (siehe Bild 6). Der befohlene Bodenabtrag in Japan rund um Fukushima ist nicht sinnvoll.

Beispiel 4: Es werden in Japan gigantische Anstrengungen gemacht, damit ein Einsickern von kontaminiertem Grundwas- ser ins Meer verhindert wird. Den bisherigen Verlauf der Kontamination vom Meerwasser mit Jod-131 nach dem Unfall zeigt Bild 7:

Bild 7: Verlauf der im Meer vor dem Kraftwerk gemessenen Radioaktivität durch Jod-131, HWZ 6d. [2]

Der dicke schwarze Strich in Bild 7 ist der in Japan geltende Grenzwert, er wurde zu Anfang überschritten, dann wurde die Radioaktivität im Meer verteilt und klang an den Meßstellen ab.

Zum Vergleich: Es gibt Radon-Heilbäder, wo die Patienten Heilung erfahren durch die Strahlung des Radons. Die Wettinquelle in Bad Brambach hat einen Radongehalt von 25 000 Bq/Liter (grün in Bild 7). In Gebieten mit Urgestein enthält das Trinkwasser z.B. 1000Bq Rn/Liter, das ist in nordischen Ländern der Fall, z.B. Finnland. Wieder ist der festgelegte Grenzwert politischer Natur, denn bei Konzentrationen der Radioaktivität in Heilbä- dern erfahren die Patienten heilende Effekte. Dabei ist noch zu berücksichtigen: Die biologische Wirksamkeit der alpha-Strahlung des Radon ist 20-mal höher als diejenige von beta- oder gamma-Strahlung wie bei J-131.

Japan wirft bei den Aufräumarbeiten gigantische Geld-Beträge zum Fenster hinaus, um die belanglose Kontamination vom Erdreich und vom Meerwasser zu verringern.

Die Strahlenschutzgesetzgebung gilt nur für den Umgang mit Kernbrennstoffen. Sie gilt NICHT für Höhenstrah- lung, Bodenstrahlung oder im medizinischen Bereich. Das ist ein Fehler in der Gesetzgebung.

Die Folgen der Strahlenhysterie in Deutschland:

· Ausstieg aus der sicheren Stromversorgung durch Abschaltung der Kernkraftwerke

· Sicherheitszonen um die KKW‘s: von 2/10/25km auf 5/20/100km erweitert

· Schaffung eines Strahlenschutzgesetzes, also Höherstufung der „Strahlengefahr“

· Neue Strahlenschutzverordnung: bisher ca. 100 Seiten, jetzt ca. 600 Seiten

Dieses sind alles Maßnahmen der Politik, es sind keine Forderungen der Strahlen-Fachleute. In einem persön- lichen Mail hat der damalige Präsident der Strahlenschutzkommission, Herrn Prof. Wolfgang-Ulrich Müller die Erweiterung der Sicherheitszonen als Forderung der Politik bestätigt. Man darf davon ausgehen, daß das neue Strahlenschutzgesetz und die neue Strahlenschutzverordnung politische Maßnahmen sind, um die Strahlen- hysterie in Deutschland zu erhalten und damit den Ausstieg aus der sicheren Stromversorgung zu begründen.

Die Strahlenschutzgesetzgebung sollte dringend korrigiert werden, denn durch sie wird keine reale Ge- fahr abgewehrt. Diese Forderung wurde bereits weltweit von unzähligen Wissenschaftlern in mehreren 1000 Veröffentlichungen begründet. In Deutschland herrscht dazu Stille in den allgemeinen Medien, nur wenige Fachleute – nicht die „Experten“ – wissen Bescheid und äußern sich dazu.

Wie konnte zu der als falsch kritisierten Strahlenschutzgesetzgebung kommen?

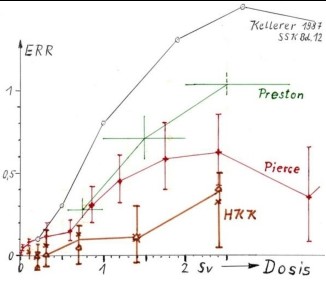

Die heutigen Kenntnisse zur schädlichen Wirkung von Strahlung beruhen auf den Untersuchungen an den Überlebenden der Kernwaffenexplosionen von Hiroshima und Nagasaki. Es hat sich dort eine Zunahme des Krebsrisikos ab etwa der Dosis 0,5 Sievert gezeigt, siehe Bild 8 und 9.

Bild 8: Zunahme des Krebsrisikos bei den Überle- benden in Hiroshima und Nagasaki [6]

Bild 9: Excess relative risk = f (Dosis) Hiroshima und Nagasaki mit Meßungenauigkeit

Die recht eindeutige lineare Abhängigkeit in Bild 8 ohne Angabe der Fehlergrenzen ist störend, daher wurden aus Arbeiten verschiedener Autoren die Diagramme auf einem Blatt in Bild 9 dargestellt, wenn Rückschlüsse auf die Fehlergrenzen durch die Vertrauensbereiche möglich waren. Der Zusammenhang in der Zunahme des Krebsrisikos ist klar, die Steigung der Geraden ist ungewiß.

Man schließt aus dem bei hoher Dosis ab ca. 0,5Sv sichtbaren linearen Zusammenhang, daß auch bei beliebig kleiner Dosis von 1mSv noch ein Krebsrisiko besteht. Zusätzlich man macht die Annahme, daß dieses Risiko unabhängig von der Zeit sei, in welcher die Dosis einwirkt. Das heißt, die in kurzer Zeit wie bei der Explosion festgestellte Wirkung zum Krebsrisiko sei auch vorhanden, wenn sich dieselbe Dosis über lange Zeit aufsum- miert. Das ist eine unbeweisbare Annahme, sie hat sich eingebürgert und bestimmt weltweit die Strahlen- schutzgrundsätze:

Jede noch so kleine Dosis ist schädlich und daher zu vermeiden. (§28 StrlSchV1989)

Der Fehler dieser Annahme wird ersichtlich beim Vergleich mit der Wirkung des Giftes und Kanzerogens Etha- nol: Eine Flasche Schnaps in Minuten hinunter gekippt ist schädlich, vielleicht sogar tödlich. Die gleiche Dosis über ein ganzes Jahr ist aber nicht schädlich.

Mit der Annahme des hypothetischen Risikos jeder noch so kleinen Dosis werden häufig hypothetische Todesopfer berechnet. Das geschieht bei Strahlung infolge Kerntechnik, niemals jedoch infolge Zusatzbestrah- lung durch Flugreisen oder im medizinischen Bereich.

Es gibt immer wieder bedeutende Stimmen, die Kritik an diesem Vorgehen mit Strahlung äußern. So sagten einige Mitglieder der International Commission on Radiological Protection ICRP zum Strahlenrisiko bei kleiner Dosis: Es ist „speculative, unproven, undetectable and „phantom“ [7]. Ein Phantom ist ein Geisterbild oder Gespenst.

Deutschland glaubt an diese Gespenster und steigt daher aus seiner Stromversorgung aus.

Die Fehler der Strahlenschutzgesetze sind den Authoritäten in Sachen Strahlung in Deutschland (und weltweit) bekannt, aber sie schweigen, denn sie werden für das SCHÜTZEN bezahlt.

Der Gesetzgeber sind bei uns die Abgeordneten im Bundestag. Es sind Menschen, und Menschen können ir- ren. Der Blick in die Geschichte zeigt immer wieder Irrtümer des Gesetzgebers.

Der Unfall von Tschernobyl in 1986

Der Tschernobyl-Reaktor ist etwas ganz anderes als alle anderen Reaktoren in der westlichen Welt. Er ist mit Graphit moderiert und mit Wasser gekühlt, und das birgt von Haus aus Gefahren. Rußland hat gezeigt, daß man den Reaktor sicher betreiben kann, wenn man alle Vorschriften beachtet. Das hatte man jedoch 1986 nicht gemacht und den Unfall verursacht. Mit Graphit moderierte und mit Wasser gekühlte Reaktoren gab es in den 1940-er Jahren in den USA ebenfalls, aber sie wurden bald still gelegt, weil man die Gefahren erkannte.

Ursprünglich waren die Reaktoren dieser Bauart zur Produktion von Waffen-Plutonium konstruiert worden, in den USA wie auch in Rußland. Während in den USA diese Reaktoren wegen der ihnen innewohnenden Gefah- ren bald still gelegt wurden, hatte man sie in Rußland zur Stromerzeugung optimiert. Heute gibt es in Rußland noch 10 Reaktoren des Typs Tschernobyl mit jeweils 1000 MWel in Betrieb. Die 2 Reaktoren dieser Art in Li- tauen wurden auf Forderung der EU still gelegt, um dem Land die Aufnahme in die EU zu ermöglichen.

Der Unfall von Tschernobyl geschah während eines Versuches, den man beim Abfahren des Reaktors machen wollte. Dabei wurden Fehler gemacht und mehrfach wichtige Warnsignale nicht beachtet. Es kam zu einer Leis- tungsexkursion und der Reaktor wurde zerstört. Es gab mehrere Brände, konventionelle sowie ein Brand des durch nukleare Wärme aufgeheizten Reaktorgraphits. 10 bis 20% des radioaktiven Inventars wurden freigesetzt und mit den Rauchgasen in große Höhen transportiert und mit dem Wind weiträumig verteilt.

Es gab Todesopfer in Tschernobyl: Von den 134 Strahlenkranken starben 28 Personen als Folge der Strahlen- krankheit. Diese Todesopfer waren überwiegend Feuerwehrleute der ersten Stunde, es wurde dort offensicht- lich nicht auf die Strahlengefährdung geachtet [9].

Hätte man diese Feuerwehrleute mit Strahlungsmeßgeräten versehen, bzw. nicht in die Bereiche mit hoher Strahlung geschickt, dann wären sie nicht erkrankt und es hätte auch keine Todesopfer gegeben.

Aus der Umgebung des Reaktors mit dem Radius von 30km wurden etwa doppelt so viele Menschen evakuiert wie in Fukushima. Wenn man die Daten von Fukushima als Vergleich heran zieht, kann man auf mehr als 2000 Todesopfer durch die Evakuierung schließen – dazu wurde in Medien geschwiegen.

Auch in Tschernobyl gab es mehr Evakuierungsopfer als Strahlenopfer

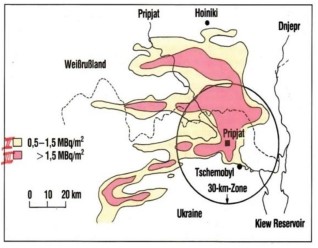

Bild 10: Bodenkontamination mit Cs-137 in der Umgebung des Reaktors [8]

Eine Bodenkontamination von 10MBq Cs-137/km² hat einen Strahlenpegel von 0,02mSv/h zur Folge. Das ist zu vergleichen mit dem Strahlenpegel im Flugzeug: Auf Reiseflughöhe in Deutschland sind es 0,006mSv/h, beim Flug nach New York werden in höherer Breite auch 0,01mSv/h erreicht (je nach Aktivität der Sonne).

Auch in Tschernobyl waren die Evakuierungen eine Folge der unsinniger Strahlenschutzgesetzgebung. Hätte man die Evakuierungen nicht gemacht und die Menschen in ihrer Heimat belassen, dann hätte man zwar Gesetze mißachtet, nicht jedoch den Menschen geschadet.

Die heutigen Strahlenwerte in der Umgebung von Tschernobyl kann man im Internet über die dort inzwischen installierten automatisierten Meßstellen aufrufen, siehe Bild 11:

Bild 11: Ortsdosisleistung am 13.1.2016 in der „Todeszone“ von Tschernobyl, gemessen in nSv/h [10]

Die Strahlung ist jetzt gesunken, aber gegenüber der Zeit vor dem Unfall immer noch erhöht, das wird noch sehr lange Zeit so bleiben. Sie erreicht aber NICHT den Strahlenpegel im Flugzeug, der bei uns 100-fach höher ist als am Boden.

Um die Ruine des zerstörten Reaktors wurde 1986 ein erster Sarkophag gebaut. Inzwischen wurde noch ein 2- ter Sarkophag über den ersten gebaut. Den Bau konnte man zeitweise verfolgen [10], hier einige Bilder:

Bild 12: 2-ter Sarkophag am 20. Juni 2013

Bild 13: 2-ter Sarkophag am 27.1.2014

Der Bau kostete über 2 Mrd. EURO. Er wiegt das 3-fache vom Eifelturm. Durch diesen Bau soll verhindert wer- den, daß Radioaktivität aus den Kellerräumen vom geschmolzen Kernmaterial in die Umwelt gelangt [11]. Auch das ist eine Maßnahme, die nicht als Schutz vor Strahlung gerechtfertigt werden kann, denn das Material unten im Keller ist ausgeglüht, alle Elemente mit niedrigem Schmelz- und Siedepunkt sind schon entwichen. Es ist sinnvoll, Menschen am Einzudringen in die Ruine zu hindern, mehr ist nicht erforderlich.

Ein Betretungsverbot und ein Zaun in 100 Meter Entfernung rund um die Ruine hätten zum Schutz der Menschen ausgereicht. 2 Mrd. EURO könnte man auch sinnvoller verwenden, zum Beispiel zur Versor- gung der Bevölkerung im medizinischen Bereich.

Im Kontrollraum des Unglückreaktors hat man heute einen Strahlenpegel wie im Flugzeug: 0,006mSv/h. Herr Dr. Walter Rüegg aus der Schweiz konnte dieses bei seinem Besuch dort im Jahre 2015 messen.

Der Tschernobyl-Unfall war die schlimmste Katastrophe in der friedlichen Anwendung der Kerntechnik. Durch das spezielle Risiko der Kerntechnik – das ist die Strahlung – verloren 28 Menschen ihr Leben, und das auch nur weil die Feuerwehrleute ungeschützt in die brennende Ruine geschickt worden sind.

Zu Tschernobyl-Opfern gibt es von den Fachmedien viele verschiedene Zahlen, dazu hat Frau Dr. Anna Vero- nika Wendland eine exzellente Zusammenfassung geschrieben [12]. Es wird empfohlen, diese Fleißarbeit zu beachten, Frau Wendland kennt viele KKW’s bestens von innen.

Als Schlagzeile findet man oft Angaben von hypothetischen Opfern durch Strahlung, die aufgrund der Annahme „jedes Becquerel kann töten“ – siehe oben – berechnet wurden. Auf der Tagung von IAEA und WHO in Wien „20 Jahre nach Tschernobyl“ hatte man sich auf 4000 virtuelle Todesopfer geeinigt. Wenn man diese Berech- nung akzeptiert, dann sollte man diese Berechnung von virtuellen Todesfällen auch auf die Zusatzbestrahlung beim Fliegen anwenden und dsgl. mit anderen Risiken machen und sagen:

Die Zusatzbestrahlung beim Fliegen ergibt weltweit jährlich 5000 virtuelle Krebstodesopfer.

Und wenn man aus der Dosisabhängigkeit des Krebsrisikos beim Alkoholkonsum dieselben Berech- nungen macht wie bei Strahlung, dann kann man jährlich 2 Millionen virtuelle Krebstodesopfer durch Alkohol allein für Deutschland ausrechnen – es sterben in Deutschland aber nur ca. 800 000 Pers./a.

Dieser Vergleich zeigt die Unsinnigkeit solcher Rechnungen, egal bei welchem „Schadstoff“ und in welchem Zusammenhang sie gemacht werden (siehe z.B. aktuell das Thema Stickoxid beim Diesel).

Und jetzt kommt der Hammer:

Strahlenhysterie verhindert die nukleare Abrüstung von 34 t Waffen-Plutonium in der USA

Vor langer Zeit hatten Gorbatschow und Reagan eine nukleare Abrüstung eines Teiles des nuklearen Waffen- materiales vereinbart. Das spaltbare Uran-235 wurde inzwischen verdünnt und in Kernreaktoren zur Stromer- zeugung eingesetzt, diese Gefahr ist beseitigt. Etwas schwieriger gestaltet sich die Abrüstung vom Plutonium, je 34 Tonnen aus USA und Rußland müssen abgerüstet werden. In Rußland gibt es dazu keine Probleme, es kann im Natrium-Brüter eingesetzt werden, denn Rußland beherrscht diese Technik.

In den USA sieht es anders aus, denn seit der Präsidentschaft von Carter wurden viele Aktivitäten im nuklearen Bereich eingestellt: Es gibt keine Wiederaufarbeitung der eingesetzten Brennelemente, es gibt kein Programm zum geschlossenen Brennstoffkreislauf mit Schnellem Brüter. Um daher das Waffen-Plutonium der USA im Reaktor einzusetzen und so zu beseitigen, sind Brennelemente aus einem Gemisch von Plutoniumoxid und Uranoxid herzustellen, das nennt man MOX-Brennelemente. Die Technik wurde in Deutschland entwickelt, Siemens hatte in Hanau eine neue MOX-Anlage gebaut. Mit dieser Anlage hätte man die 34 Tonnen Waffen- Plutonium der USA in 6 Jahren in MOX-Elemente einbringen können, um sie dann im Reaktor zur Stromerzeu- gung zu benutzen und das Waffen-Plutonium so zu beseitigen.

Diese neue Anlage in Hanau hatte keine Aussicht, in Betrieb gehen zu können, weil zur Zeit ihrer Fertigstellung Joschka Fischer in Hessen Minister geworden war. Eine Genehmigung zur Inbetriebnahme war ohne Aussicht. Siemens hat die Anlage schließlich wieder abgebaut, sie stand einige Jahre in Hanau im Hof in Containern ver- packt. Auch ein angedachter Verkauf an China gegen ein Spottgeld war aussichtslos. Schließlich wurde die Anlage verschrottet [13].

Da die Verpflichtung der USA zur Abrüstung der 34 Tonnen Plutonium wegen der abgeschlossenen Verträge weiterhin besteht, wurde in den USA der Bau einer eigenen MOX-Anlage in Savannah River Site in South Carolina in Angriff genommen. Diese Anlage ist zu 70% fertig, aber in 2018 wurde der Bau wegen Kostenexplo- sion eingestellt. Der Grund der Kostenexplosionen ist in immer neuen Auflagen der Behörden zu sehen, die wiederum eine Folge der weltweit grassierenden Strahlenangst ist. Bild 14.

Bild 14: Kostenexplosion bei MOX-Anlagen, Vergleich Deutschland – USA

Die MOX-Anlage in Hanau hatte etwa 1 Mrd. DM gekostet, die wesentlich kleinere und zu 70% fertige Anlage in den USA hat schon 17 Mrd. US$ verschlungen und würde bis zur Fertigstellung ca. 50 Mrd. US$ kosten [14].

Aus 34 Tonnen Waffen-Plutonium könnte man 2000 Nagasaki-Bomben bauen, oder bei modernster Waf- fentechnik ein Vielfaches davon. Hoffen wir, dass es gut bewacht wird und niemals in falsche Hände gerät — das wäre eine wirkliche Gefahr, >1000-fach größer als die friedliche Nutzung der Kerntechnik.

Es läuft einiges falsch mit der Kernenergie, besonders in Deutschland. Der Grund sind falsche Gesetze, mit denen eine nicht existierende Strahlengefahr abgewehrt werden soll (§28 StrlSchV1989). Gesetze werden von Menschen gemacht und Menschen können irren. Das ist beim Strahlenschutz sicher der Fall. Der Kernenergieausstieg ist eine Folge der jahrelang geschürten Strahlenangst. Fachleute der Strahlenbiologie und aus der Kernenergiebranche protestieren gegen diese falschen Gesetze, aber sie kommen nur auf ihren Fachtagungen oder in ihren Fachzeitschriften zu Wort. Die hauptamtlichen Strah- lenschützer sehen die Dinge teilweise anders, denn ihnen geben falsche Gesetze die Lebensgrundlage. Unsere Massenmedien hätten die Macht zu einer Veränderung, aber bisher haben sie diese Macht nicht genutzt, das ist bedauerlich. Manchmal wird daher von Lückenmedien oder Lügenmedien gesprochen.

Literatur

[1] Gerlich & Tscheuschner, Falsifizierung der atmosphärischen CO2 –Treibhauseffekte im Rahmen der Physik [2] www.grs.de und Fachtagung „Strahlenschutz – Ein Jahr nach Fukushima“ des FS, am 8./9.3.2012, in Mainz [3] www.ncbi.nim.gov/pmc/articles/PMC3608616

[4] StrahlenschutzPRAXIS 4/2018, Seite 10 bis 21

[5] https://www.flightradar24.com

[6] Strahlenschutz, Radioaktivität und Gesundheit, 4. Auflage 1991, BtMLU, ISBN 3-910088-82-1

[7] J Radiol Prot. 2013 Sep;33(3):497-571

[8] “Radioaktivität, Risiko – Sicherheit”, Kernforschungszentrum Karlsruhe 1991

[9] Bericht der sowjetischen Delegation auf der Konferenz am 25. – 28.8.1986 bei der IAEA in Wien

[10] https://chnpp.gov.ua/ru/home

[11] Buch von Anatoly N. Tkachuk „Ich war im Sarkophag von Tschernobyl“

[12] https://nuklearia.de/2017/04/25/tschernobyl-fakes-und-fakten/ [13] Wolfgang Stoll „Plutonium in Hanau“, ISBN 978-3-939033-18-9 [14] www.nukeklaus.net verschiedene Bericht zum Thema „Plutonium“

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||