Demokratie ist Volksherrschaft, nicht Parteienherrschaft. Deshalb müssen wir sie alle abschaffen, feuern wegen Unfähigkeit!

Die Energiewende ist ein gigantisches Projekt, das die Umwelt retten soll – und dafür die Natur zerstört.

»Wenn es Wissenschaft ist, gibt es keinen Konsens. Wenn es Konsens gibt, ist es keine Wissenschaft.« – Michael Crichton

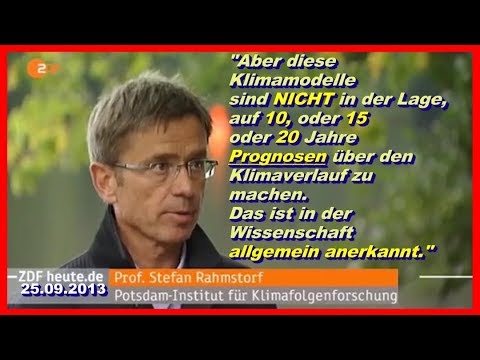

Die Wissenschaft der Klimaforschung ist ein offenes Buch mit vielen Unbekannten und die momentanen Klimamodelle um unsere Klimazukunft vorauszusagen sind blanker Unsinn – Kaffeesatzleserei. Erst 2013 sagte ein gewisser Herr Rahmsdorf am 25. September 2013, diese Klimamodelle sind nicht in der Lage auf 10, 15 oder 20 Jahre Prognosen über den Klimaverlauf zu machen. Das ist in der Wissenschaft allgemein anerkannt. Wie soll das dann über 50 oder 100 Jahre funktionieren. Ob das CO2 solchen gravierenden graviernden Einfluß wie vom IPCC behauptet wird, um die Erdtemperatur bis 2100 Jahren von 14,8 °C (PIK Potsdam, ZDF) auf über 17 °C zu katapultieren (Greenpeace), ist mit nichts bewiesen. Momentan ist das blanke Panikmache. Das Klima hat sich schon immer verändert, täglich, jährlich, u.s.w. Vielleicht hat der Papst ja schuld, er ist ja Gottes Stellvertreter, der muss es doch eigentlich wissen.

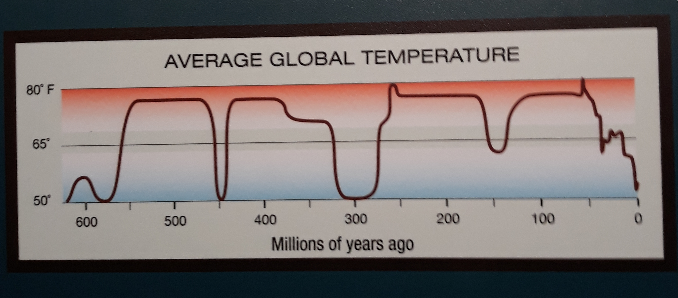

Mittlere globale Temperatur – Graphik: Perot Museum of Nature and Science 80°F gleich 26,67C

Als Demokraten brauchen wir in der Klimadiskussion Meinungsvielfalt, Rede und Gegenrede. Klimawandel gibt es so lange auf der Erde eine Atmosphäre besteht, weit bevor der Mensch aus Fröschen und Lurchen entstand. Die Alpen sollen vor 25 Mio. Jahren entstanden sein, durch den noch laufenden Zusammenprall des europäischen und des afrikanischen Kontinent, Kontinentaldrift nennen wir das. Wer den höchsten deutschen Berg, die Zugspitze besteigt, wandert über uralte Korallen, die vor 200 Mio. im Urmeer Thetys entstanden. Es waren also tropische Verhältnisse, mitten im jetzigen Bayern. Ein Klima, wie geschaffen für Algen, Muscheln und Schnecken.

Auszug aus dem Sonderheft Klimawandel für die Schule vom Weltwoche Verlags AG:

Die Wahrheitsfindung geschieht in der Wissenschaft nicht per Mehrheitsentscheid. Als Albert Einstein vom Buch «Hundert Autoren gegen Einstein» hörte, scherzte er: «Warum einhundert? Wenn sie recht hätten, würde ein Einziger genügen!»

Bild: © Lothar Strenge – Nach der Noternte im Juli 2018 –

Bild: © Lothar Strenge – Nach der Noternte im Juli 2018 –

Prophezeiter Weltuntergang der Bildzeitung vom 22.02.2007 am 22.02.2020, also vor zwei Tagen. Eintrag am 24.02.2020.

Das Thema CO2 Lüge habe ich erst jetzt einige Monate nach der ersten Veröffentlichung dieser Seiten ganz oben angesetzt, weil mich ärgert, wie unsere gesamte politische Parteienriege ihren Kopf immer noch als Hutständer benutzt und diesen Trotteln des IPCC hinterher läuft, die GRÜNEN ganz vorneweg. Sie nutzen die Naivität in der Bevökerung, siehe Hambacher Forst. Bei der Braunkohleverbrennung muss nur der Feinstaub gefürchtet und abgefiltert werden, der ist absolut schädlich, nicht nur für menschliche Organe, auch die Tiere leiden darunter, können es uns nur nicht mitteilen. Die CO2 Emission ist fast völlig unbedeutenden, weil diese menschliche Emission, Verursachung, nur maximal 3 % der gesamten Emissionen der Erde ausmachen, wie die Meere zum Beispiel. Siehe auch westlich von Neapel die vulkanischen Felder von Solfatara, da treten permanent Gase aus, bei ca. 200 ° Celsius neben Wasserdampf, Schwefel, Antimon, Quecksilberverbinden. Von diesen vulkanischen Feldern gibt es tausende auf dem Planeten, siehe auch Island oder, noch gefährlicher, der pazifische Feuerring.

Aber das will keiner wissen, weil diese vielen Trottel der vielen NGOs keine Spenden mehr bekämen. Die Parteien hatten die letzten Jahre Zeit genug sich zu informieren, wie weit die Klimaskeptiker recht haben mit ihren Fakten. Die deutschen Ableger in Potsdam des IPCC tun sich da besonders hervor. Wir sollten diese Kraft, damit meine ich diese vielen fehlinvestierten Milliarden Euro, lieber dem Umweltschutz widmen, das bringt uns sofortigen Nutzen, zum Beispiel dem Totalverbot von Gyphosat. „Wir schaffen das“ Frau Merkel, in 10 Jahren bis 2030 eine Totalumstellung unserer Landwirtschaft auf Bioanbau. Alle neuen Erkenntnisse unserer Wissenschaftler bringt Deutschland die Nummer 1 in der Nachhaltigkeit ein und alle lernen von uns, weil wir die Patente darauf halten.Verschenkt wird nichts, zumindest nicht ohne Gegenleistungen.

Es wird zwar langsam wärmer auf der Erde, ganz langsam, aber das hat nichts mit dem CO2 Gehalt in unserer Athmosphäre zu tun, sondern mit der etwas höheren solaren Aktivität der Sonne. Dafür gibt es auch seit langem Temperaturmessungen, die das bestätigen.

Es kann keinen Treibhauseffekt geben, weil es einen offenen Himmel gibt. CO2 kommt nur zu 0,038 Prozent in der Atmosphäre vor, der menschengemachte Anteil des CO2 liegt bei drei Prozent des gesament CO2 Gehalts.

http://www.klimaskeptiker.info/beitraege/malberg_solar.html

Der folgende Text ist ein Auszug aus www.klimaskeptiker.info -von Horst Mahlberg, Uni.-Prof. (a.D.) für Meteorologie und Klimatologie.

Quo vadis Klima?

Betrachtet man die grundsätzliche Temperaturentwicklung von der mittelalterlichen kleinen Eiszeit bis heute, so weist sie unverkennbar einen wellenartigen, sinusförmigen Verlauf auf. Die Wellenlänge beträgt rund 200 Jahre. Synchron dazu zeigt die solare Aktivität das gleiche langfristige Schwingungsverhalten. Bei der periodischen Zu- und Abnahme der solaren Aktivität handelt es sich offensichtlich um den aus der Astrophysik bekannten „De-Vries-Zyklus”, dessen mittlere Periode 210 Jahre beträgt. Die beobachteten Zyklusminima der solaren Aktivität lagen in den letzten 350 Jahren im 17. (Maunder Minimum) und im 19. Jahrhundert (Dalton Minimum). Die Maxima der solaren Aktivität traten um 1800 und 2000 auf. Die Klimaentwicklung seit der mittelalterlichen Kleinen Eiszeit folgt dem solaren De-Vries-Zyklus (u. U. derzeit verstärkt durch den im Mittel 88-jährigen Gleisberg-Zyklus).Aufgrund dieses Zusammenhangs von periodisch sich ändernder Sonnenaktivität und der Klimaentwicklung in den letzten 300 Jahren muß man folgern: Nach der derzeitigen Wärmeperiode folgt mit hoher Wahrscheinlichkeit entsprechend dem langperiodischen Sonnenverhalten ein weiteres zyklisches Minimum der solaren Aktivität und damit eine demTreibhauseffekt entgegenwirkende Abkühlung im Verlauf des 21. Jahrhunderts. Die von den Klimamodellen berechnete fortschreitende Erwärmung erscheint vor diesem Hintergrund höchst unwahrscheinlich

Wie die dramatische Klimaentwicklung zwischen 1661 und 1700 (Zentralenglandreihe) sowie von 1800 bis 1850 (Mitteleuropareihe) zeigt, als die 10-jährigen Mitteltemperaturen in nur vier bzw. fünf Jahrzehnten um -1,0°C (K) sanken, können Abkühlungen abrupt einsetzen und über viele Jahrzehnte das Klima bestimmen.

Als schwerwiegender Fehler könnte sich in der Klimazukunft erweisen, den solaren Einfluß auf den Klimawandel falsch eingeschätzt zu haben. Wir werden uns nach dem periodischen Verhalten der Sonnenaktivität voraussichtlich schneller in einer weiteren Abkühlungsphase befinden als uns lieb ist. Einen ersten Temperatureinbruch gab es in den 1960er/70er Jahren, als die Sonnenfleckenzahl vorübergehend um 25% zurück ging und sich als Folge des verringerten solaren Energieflusses die Nordpolarregion um mehrere °C (K) dramatisch abkühlte. Aus diesem Grund erscheint es dringend geboten, Klimafolgestrategien für den Fall einer raschen Abkühlung zu entwickeln. Allein an eine fortlaufende anthropogen verursachte Erwärmung zu glauben, könnte sich schon in wenigen Jahrzehnten als einäugig erweisen. Jahren beschleunigt hat. Dieses mit dem anthropogenen Treibhauseinfluß zu begründen, ist durch nichts bewiesen. Zum einen ist die solare Aktivität auf dem höchsten Niveau seit weit über 300 Jahren, und zwar noch um 25 – 30% höher als beim Wärmehöhepunkt der 1790er Jahre. Zum anderen können bei Abkühlungen wie Erwärmungen positive Rückkopplungen mit anderen Klimafaktoren auftreten, was eine Verstärkung des Prozesses zur Folge hat. So wird durch eine globale Erwärmung die mit Eis und Schnee bedeckte Fläche kleiner. Das führt zu einer verminderten Reflexion der Sonnenstrahlung, d.h. zu einer erhöhten Absorption und damit einer sich weiter verstärkenden Erwärmung. Analoges gilt für den Selbstverstärkungsprozess in Abkühlungsperioden, wenn die schnee- und eisbedeckte Fläche anwächst und sich dadurch die globale Albedo erhöht.

Schlußbetrachtungen

Nach den obigen Ergebnissen über die globale wie mitteleuropäische Klimaentwicklung der vergangenen 150 bzw. 300 Jahre wird der anthropogene Treibhauseffekt auf den Klimawandel im UN-Klimabericht 2007 wesentlich überschätzt und in der öffentlichen Darstellung in wissenschaftlich unzulässiger Weise dramatisiert. Unsichere, auf Hypothesen beruhende und im Konjunktiv gemachte Szenarienaussagen werden wie Fakten behandelt. Die daraus resultierende derzeitige Klimahysterie und der unausgegorene CO2-Aktionismus sind vor dem Hintergrund der bisherigen Klimaentwicklung nicht nachvollziehbar. Nicht der Mensch, sondern die veränderliche Sonnenaktivität ist aufgrund der 300-jährigen Klimadiagnose die treibende Kraft, ist der „global player” in unserem Klimasystem. So hat zur globalen Erwärmung im Zeitraum 1850-2000 von +0,6°C (K) die CO2-Zunahme um 35% lediglich +0,1°C (K) beigetragen. Was aber bedeutet das für die Klimapolitik? Es wäre ein Irrtum, würde man folgern, damit sei der Mensch aller Klimaprobleme enthoben.

Zum einen müssen wir uns, wie alle unsere Vorfahren, auf weitere naturgegebene globale und regionale Klimaänderungen, d.h. auf wärmere und kältere Perioden, einstellen. Mit der Entwicklung entsprechender Strategien gilt es, sich vorausschauend auf verändernde Lebensbedingungen einzustellen. Dabei ausschließlich von einer fortschreitenden Erwärmung auszugehen, erscheint in Anbetracht der langperiodisch sich ändernden Sonnendynamik einäugig. In Abwandlung eines geflügelten Wortes kann man sagen: Die nächste Abkühlung (Kleine Eiszeit) kommt bestimmt. Daran wird der Mensch kaum etwas ändern können.

Die Anstrengungen zur globalen Reduzierung der CO2 -Emissionen sollten in erster Linie aus energiepolitischen Überlegungen abgeleitet werden. Vor dem Hintergrund der Nachhaltigkeit erscheint es dringend geboten, den Schutz der Ressourcen um der Ressourcen – und damit unserer Nachkommen – willen zu betreiben. Selbst wenn unsere fossilen Energiereserven noch über 100 Jahre reichen, was sind, abgesehen von ihrer zunehmenden Verknappung/Verteuerung, ein oder zwei Jahrhunderte vor dem Hintergrund der Menschheitsentwicklung? Auch ist zu bedenken, daß der Energiebedarf bei einem Rückgang der Temperatur höher sein wird als bei der „prognostizierten” Erwärmung Vor diesem Hintergrund kommt dem Einsatz regenerativer Energien als Ergänzung zu den konventionellen Energieträgern eine wichtige Rolle zu. Allerdings sollte man auch die Grenzen beim Einsatz erneuerbarer Energien klar erkennen. So stehen z.B. uns in Mitteleuropa in der kalten und dunklen Jahreszeit, wenn der Energiebedarf besonders hoch ist, im Mittel nicht mehr als 10% der Sonnenenergie im Vergleich zu den Sommermonaten zur Verfügung. Entsprechend liefern meine Solarröhren an den vielen trüben Herbst- und Wintertagen bei Kollektortemperaturen unter 20°C nicht einmal genug Wärme für das tägliche Spülwasser.

Last but not least sollte dem regionalen und überregionalen Umweltschutz höchste Priorität eingeräumt werden. Die Reinhaltung von Luft, Wasser und Boden, der Erhalt der Wälder usw. kommen den Menschen unmittelbar zu gute und stellen in der Summe einen effektiven und nachhaltigen Beitrag zum Klima und zur Lebensqualität auf unserem blauen Planeten dar.

Ende Auszug Klimaskeptiker.

Abbildung 2: 10-jährige globale Mitteltemperatur

1851 – 2000

Stickstoffdioxyd oder Nitrogendioxid

Stickstoffdioxyd oder Nitrogendioxid ist ein giftiges, stechend chlorähnlich riechendes Gas, das zur Gruppe der Stickoxide gehört. Luft besteht hauptsächlich aus den zwei Gasen Stickstoff (rund 78,08 Vol.-%) und Sauerstoff (rund 20,95 Vol.-%). Daneben gibt es noch Argon (0,93 Vol.-%), CO² -Kohlenstoffdioxid (0,04 Vol.-%) und andere Gase in Spuren.

Stickoxide (NO, NO2, NOx, NOy)

Unter Stickoxiden versteht man eine ganze „Familie“ von oxidierten Stickstoffverbindungen. Sie sind an vielen sog. Schlüsselreaktionen in der Troposphäre beteiligt. Sie bestimmen (neben Strahlung und VOC) die troposphärische Ozonproduktion („SommerSmog“). Die Salpetersäure (HNO3) ist mittlerweile die Hauptkomponente, die den pH-Wert des Regens erniedrigt („Saurer Regen“). Die Verweilzeit der Stickoxide beträgt einige Stunden bis zu 1-2 Tagen. Primär wird Stickstoffmonoxid aus atmosphärischem Stickstoff (N2) und Sauerstoff (O2) bei Temperaturen >1000°C gebildet. Diese Temperaturen erreicht man in Verbrennungsmotoren, aber auch bei Blitzen. In der Nordhemisphäre stammt das NO zu über 90% aus anthropogenen Quellen. In bodennahen Luftschichten wird NO durch Ozon zu Stickstoffdioxid (NO2) oxidiert, aber durch Strahlung auch wieder zurückgebildet, so dass sich in Abhängigkeit von der Ozonkonzentration und der Strahlung relativ rasch ein Gleichgewicht zwischen NO und NO2 einstellt. Deshalb fasst man diese beiden Komponenten auch zu NOx (=NO + NO2) zusammen. Im Verlaufe der „luftchemischen Alterung“ werden NO und NO2 zu höher oxidierten Verbindungen konvertiert (hauptsächlich salpetrige Säure (HNO2) und Salpetersäure (HNO3)). All diese Komponenten fasst man unter den Begriff NOy zusammen; das sind also alle Stickoxide mit einer Oxidationszahl >= 2: NOy = {NO, NO2, NO3, 2×N2O3, 2×N2O5, HNO2, HNO3, HNO4, PAN & Homologen, Alkylnitrate, …). Letztendlich werden die Stickoxide durch Auswaschprozesse wieder aus der Atmosphäre entfernt. Text Deutscher Wetterdienst unter Atmosphärenbeobachtung

In den Zeitreihen ist kein Trend erkennbar. Die ausgeprägten jahreszeitlichen Konzentrationsschwankungen sind durch verstärkten photochemischen Abbau im Sommer und stärkere Quellen im Winter verursacht.

Die erwartete Abnahme der atmosphärischen Mischungsverhältnisse verursacht durch die fortschreitende Ausrüstung der Kraftfahrzeuge mit Katalysatoren wurde nicht beobachtet. Ursachen könnten die Vergrößerung der Kfz-Flotte, Zunahme von Fahrleistung und Geschwindigkeit oder auch der gestiegene Anteil an Dieselfahrzeugen sein. Inwieweit biogene Quellen, insbesondere an Stationen mit geringer Stickoxidbelastung wie dem Hohenpeissenberg, eine Rolle spielen, ist noch nicht hinreichend geklärt.

Messtechnik

Stickoxide werden am Observatorium Hohenpeissenberg im Rahmen des GAW Programmes kontinuierlich mit verschiedenen Messverfahren gemessen.

Stickstoffmonoxid und Stickstoffdioxid werden mit 2 verschiedenen Messverfahren kontinuierlich überwacht: Bei dem Ozon-Chemolumineszenzverfahren (links) wird NO direkt und NO2 nach Umwandlung in einen Photolysekonverter als NO bestimmt, während beim Luminol-Chemolumineszenzverfahren (rechts) NO2 direkt und NO nach Umwandlung zu NO2 (über ein Chromtrioxid-Filter) gemessen wird. Letzteres Verfahren dient als Backup und zur Qualitätskontrolle. Weiterhin ist es für den mobilen Einsatz (Meßkampagnen etc.) geeignet. Es gibt nicht für jede Stickoxidkomponenete ein eigenes Meßverfahren. Wichtig ist aber die Summe aller reaktiven Stickoxideverbindungen mit einer Oxidationszahl 32 (NOy ) zu kennen. Alle NOy-Komponenten werden in einem Konverter (Eigenbau) an einer heißen Goldoberfläche in Gegenwart eines Reduktionsmittels (Kohlenmonoxid) zu NO reduziert und anschließend in einem weiteren Chemolumineszenzdetektor nachgewiesen. Ende der Informationen Deutscher Wetterdienst.

Der seit 2010 geltende EU Grenzwert von 40 µg/Kubikmeter Luft ist nicht einzuhalten.

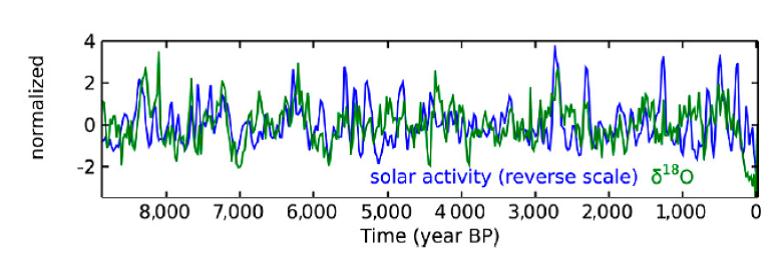

Klimawirksamkeit der Sonne während der vergangenen 9000 Jahre

Powerful correlation between sun and climate over the last 9000 years

Vergleich der Sonnenaktivität (blaue Kurve) und der asiatischen Klimaentwicklung (grüne Kurve, delta 18O eines Stalagmiten aus einer chinesischen Höhle) für die vergangenen 9000 Jahre (beide Kurven sind normiert).

Es ist eine gute Übereinstimmung der beiden Kurven zu erkennen,

was auf einen signifikanten Antrieb des Klimageschehens durch die Sonne hinweist.

- Die kalte Sonne (Fritz Vahrenholt & Sebastian Lüning)

2012-05-03 de Neue Arbeit in PNAS belegt die Klimawirksamkeit der Sonne während der vergangenen 9000 Jahre

Der Weltklimarat hält die Sonne für klimatisch wenig bedeutsam und ordnet ihr in seinen Klimamodellen eine verschwindend geringe Klimawirksamkeit zu.

Während anthropogene Faktoren fast die gesamte Erderwärmung seit 1850 erklären sollen, bilden solare Aktivitätsschwankungen nur unbedeutendes Beiwerk.

Eine neue Arbeit eines internationalen Forscherteams um Friedhelm Steinhilber vom Schweizerischen Bundesinstitut für aquatische Wissenschaften und Technologie (Eawag) hat nun weitere wichtige Hinweise für die Wirksamkeit der Sonne in der nacheiszeitlichen Klimaentwicklung gefunden.

Die Gruppe, zu der auch der Glaziologe Hans Oerter vom Alfred-Wegener-Institut in Bremerhaven gehört, veröffentlichte seine Ergebnisse im April 2012 in den Proceedings of the National Academy of Sciences (PNAS).

Anhand mehrerer antarktischer und grönländischer Eiskerne sowie globaler Baumringdaten rekonstruierten die Wissenschaftler die Sonnenaktivität für die vergangenen 9000 Jahre.

Hierzu verwendeten sie sogenannte kosmogene Beryllium- und Kohlenstoff-Isotope, 10Be und 14C, deren Häufigkeit auf der Erde von der Stärke des Sonnenmagnetfeldes und damit der Sonnenaktivität gesteuert wird.

Die Gruppe führte auch eine Spektralanalyse der neuen Sonnenaktivitätskurve durch und fand wie erwartet die üblichen charakteristischen Solarzyklen, darunter auch

- der Suess-de Vries Zyklus mit einer Periode von 210 Jahren,

- den Eddy-Zyklus (1000 Jahre)

- sowie den Hallstatt-Zyklus (2300 Jahre).

Die Minima der Millenniumszyklik, die auch als „Grand Solar Minima“ bezeichnet werde, fallen dabei meist in die Minima der Suess-de Vries Zyklen.

Überlagert ist die Zyklik durch ein langfristiges An- und Abschwellen des Signals, das durch Erdbahnveränderungen im Zusammenhang mit den Milankovic-Zyklen hervorgerufen wird.

Milankovic ist unter anderem für die warmen Temperaturen des holozänen Klimaoptimums vor 6000 Jahren verantwortlich, die deutlich über den heutigen lagen.

Dieses Erdbahnparameter-Signal zogen Steinhilber und Kollegen von ihren Daten ab, um die primäre Sonnenaktivität herauszufiltern.

Das Forscherteam verglich die neue Rekonstruktion der Sonnenaktivität mit einem Klimadatensatz, der vor einiger Zeit von Kollegen in einer chinesischen Höhle gewonnen wurde und ebenfalls die letzten 9000 Jahre abdeckt.

Die Schwankungen der 18O-Sauerstoff-Isotopen-Konzentration bilden dabei Niederschlagsschwankungen und die Stärke des asiatischen Monsuns ab.

Es ergab sich eine überraschend gute Übereinstimmung zwischen Sonnenaktivität und asiatischer Klimaentwicklung (siehe Abbildung).

Leben wir in einer klimatisch außergewöhnlichen Zeit, die alles Vorherige in den Schatten stellt?

Dafür muss man in die klimatische Vergangenheit schauen.

Anhänger des Klimaalarmismus beschränken sich dabei auf die letzte 150 Jahre und kommen zu dem vorschnellen aber persönlich erhebenden Schluss:

Ja, wir sind Teil einer Entwicklung die es noch nie gegeben hat, und wir sind auch noch selber Schuld.

Wir mächtigen Menschen haben es geschafft, uns das Klima Untertan zu machen.

Wenn man jedoch den Vergleichszeitraum einige hundert und wenige tausend Jahre nach hinten erweitert, wird schnell klar, dass es stets einen Wechsel zwischen kalt und warm gegeben hat.

Es ist ernüchternd, aber auch unsere Vorfahren hatten bereits unter dem Klimawandel zu leiden bzw. profitierten teilweise auch davon.

Geologen werden speziell dafür ausgebildet, die Naturgeschichte zu dokumentieren und zu entschlüsseln.

Das hierzu benötigte Zeitgerüst heißt „Stratigraphie“.

Und damit alles seine Ordnung hat, gibt es eine internationale Kommission zur Stratigraphie, die über Veränderungen im verwendeten Zeitschema wacht.

Eben diese Kommission hat sich im Juli 2018 zusammengesetzt und darüber diskutiert, wie man die letzten 12.000 Jahre (das sogenannte Holozän) am sinnvollsten gliedert.

Vertreter der harte Klimalinie hatten gefordert, die letzten 150 Jahre als „Anthropozän“ zu bezeichnen.

Dieser Vorschlag wurde jetzt vom Gremium klar abgelehnt.

Stattdessen unterteilte man das Holozän in drei Stufen.

Oberes Holozän: Meghalayan (4200 Jahre vor heute bis heute)

Mittleres Holozän: Northgrippian (8200 bis 4200 Jahre vor heute)

Unteres Holozän: Greenlandian (11.700 bis 8200 Jahre vor heute)

|

Experimentelle Verifikation des Treibhauseffektes 5. Mitteilung: Die IR-Strahlung der Spurengase von Chris Frey |

Eine Beurteilung der Strahlungsfähigkeit ist zunächst schwierig, da hier viele Parameter wie Konzentration, Temperatur, Hintergrund oder Anzahl der beteiligten Moleküle (Abb. 1) berücksichtigt werden müssen. Um dennoch die IR-aktiven Gase mit einer einzigen Kennziffer charakterisieren und bewerten zu können, wurde ein molarer Emissionsgrad εm eingeführt. Dabei wird die IR-Strahlungsdichte von 1 mol eines IR-Gases mit der eines Schwarzkörpers verglichen (Tab. 1). Setzt man den molaren Emissionsgrad εm von CO2 =1, erhält man den relativen Emissionsgrad εrel von IR-aktiven Gasen im Vergleich zum CO2.

Abb.1

Tatsächlich zeigt Lachgas mit einem relativen Emissionsgrad εrel von 1,26 eine etwas höhere Strahlungsfähigkeit als CO2, aber bei weitem nicht das angeblich 265-mal stärkere Treibhauspotential. Beim Methan bahnt sich sogar eine kleine Sensation an. Methan, angeblich 28-mal wirksamer als CO2, kommt nur auf 66 % der CO2-Strahlung. Ist das IPCC einer frechen Lüge überführt? Nein, soweit würde ich nicht gehen! M.E. wurde das IPCC mit einem klaren politischen Auftrag gegründet. Die Industriegesellschaft sollte als Verursacher eines angeblich gefährlichen „Global Warming“ angeprangert werden, wodurch Zielrichtung und Schuldfrage vorgegeben waren. Vor allem sollen Ängste geschürt werden, um Konsumverzicht und De-Industrialisierung zu rechtfertigen. In den folgenden Kapiteln wird nachgewiesen, dass der „Treibhauseffekt“ real aber relativ klein ist und IPCC mit fragwürdigen Methoden eine Klimahysterie entfacht, die einer sachlichen Prüfung nicht standhalten.

Was sind Emissionsgrade und wie werden sie ermittelt?

„Jeder (feste und flüssige) Körper, dessen Temperatur über dem absoluten Nullpunkt liegt, sendet Wärmestrahlung aus. Der Emissionsgrad eines Körpers (ε) gibt an, wie viel Strahlung er im Vergleich zu einem idealen Wärmestrahler, einem schwarzen Körper, abgibt.“ „Ein schwarzer Körper ist ein hypothetischer idealisierter Körper, der jegliche auf ihn treffende elektromagnetische Strahlung bei jeder Frequenz vollständig absorbiert (ε = 1).“ [3]

Oder mit einfachen Worten: Der Emissionsgrad charakterisiert die Fähigkeit eines Körpers, Wärmestrahlung zu erzeugen. Emissionsgradtabellen zeigen die Emissionsgrade ε von verschiedenen Stoffen im Bereich zwischen 0,02 bis 0,98 [4]. Dabei spielt die Oberfläche eine wesentliche Rolle. Sehr gute Strahler haben schwarze, raue Oberflächen und können Emissionsgrade ε nahe 1 erreichen, während weiße, glatte oder sogar polierte Oberflächen nur geringe Emissionsgrade nahe 0 haben.

Man unterscheidet verschiedene Emissionsgrade, die sich auch untereinander kombinieren lassen:

- Gerichtet: Die Strahlung wird in eine bestimmte Richtung pro Raumwinkel abgestrahlt

- Hemisphärisch: Der gesamte Halbraum wird pro Flächeneinheit bestrahlt

- Spektral: Die Strahlungsleistung bei einer bestimmten Wellenlänge

- Gesamt: Die Strahlungsleistung aller verfügbaren Wellenlängen

Dabei gilt: „Nach dem kirchhoffschen Strahlungsgesetz ist für jeden Körper der gerichtete spektrale Emissionsgrad gleich dem gerichteten spektralen Absorptionsgrad.“ [3]

Bei den Gasen können nur bestimmte, die sogenannten IR-aktiven Gase, Wärmestrahlung (IR-Licht) absorbieren oder emittieren.

„Gase absorbieren und emittieren elektromagnetische Strahlung, anders als andere Aggregatzustände von Materie: bei Gasen sind diese Effekte abhängig von der Wellenlänge λ der Strahlung („Strahlungsband“)… Das Strahlungsverhalten des Gasgemisches Luft ist nicht trivial zu bestimmen…und es kann auch kein gemittelter Emissionsgrad angegeben werden.“ [5]

Anders als bei Festkörpern und Flüssigkeiten ist der Emissionsgrad der IR-Gase keine Eigenschaft einer Oberfläche, sondern die eines Volumens. Dabei sind alle IR-aktiven Gasmoleküle, die sich in einem Luftpaket befinden, in einer bestimmten Art und Weise beteiligt. Dadurch sind die Emissionsgrade der Gase auch keine Konstanten, sondern von der Anzahl der beteiligten IR-aktiven Gasmoleküle abhänge Variablen (Abb. 1). Um dennoch die Strahlungsfähigkeit IR-aktiver Gase miteinander vergleichen zu können, habe ich einen molaren Emissionsgrad εm definiert. Es ist der Vergleich der IR-Strahlung von einem 1 mol (6,022 * 1023 Moleküle; Avogadro-Konstante) eines IR-aktiven Gases in einem Luftpaket mit der Strahlung eines Schwarzstrahlers. Da die IR-aktiven Gase als Linienstrahler nur ausgewählte Wellenlängen emittieren, sind ihre molaren Emissionsgrade εm deutlich kleiner als 1.

Weiter ist festzustellen, dass die IR-inaktiven Atmosphärengase, Stickstoff und Sauerstoff, Wärmestrahlung praktisch nicht streuen und auch nicht absorbieren. Die bekannte Streuung des Sonnenlichtes an den Luftmolekülen unserer Atmosphäre ist nur für das sichtbare, kurzwellige Licht relevant:

„Der Streuquerschnitt σ der Rayleigh-Streuung ist proportional zur vierten Potenz der Frequenz der elektromagnetischen Welle…. Die frequenzabhängig unterschiedlich starke Streuung von Sonnenlicht an den Teilchen der Erdatmosphäre bewirkt das Himmelsblau am Tag, und die Morgenröte wie die Abendröte während der Dämmerung“. [6]

Ohne IR-aktive Gase (und ohne Aerosole) könnten Wärmestrahlen die Erd-Atmosphäre ungehindert passieren. Ein kleiner molarer Emissionsgrad εm bedeutet somit eine hohe Transparenz und ist der Grund, dass bei einer Strahlungsmessung IR-Gase und Hintergrund immer gemeinsam gemessen werden.

Zur Messung der Emissionsgrade wird die gleiche Apparatur (Abb. 2) und Prozedur verwendet, die bereits für die Messung der CO2-Strahlung vorgestellt wurde [7]. Im Wesentlichen geht es dabei um Wärmeübertragung von parallelen, geschwärzten Oberflächen für E = 1 (wenn ε1, ε2 = 1) mittels IR-Strahlung für die Josef Stefan Gl. 1 vorgeschlagen hatte [8].

E (Strahlungsaustauschgrad) ist hier der griechische Großbuchstabe Epsilon. Bitte nicht verwechseln mit E = Bestrahlungsstärke: „Die Bestrahlungsstärke E (engl.: irradiance, radiant flux density; auch Strahlungsstromdichte) ist der Begriff für die gesamte Leistung der eingehenden elektromagnetischen Energie, die auf eine Oberfläche trifft, bezogen auf die Größe der Fläche.“

Die Stefan Gleichung wurde experimentell abgeleitet und ist der Vorläufer des berühmten Stefan-Boltzmann-Gesetzes. Gl. 1 ist die theoretische Grundlage für den erdnahen „Treibhauseffekt“. Sie sagt aus, dass ein Körper nur dann Energie (Wärme) durch Strahlung abgibt, wenn T1 > T2 ist. Das bedeutet, dass auch beim Strahlungstransport die Energie immer von „warm nach kalt“ übertragen wird. Ein Widerspruch zum II. Hauptsatzes der Thermodynamik liegt somit nicht vor. Der Begriff „Treibhauseffekt“ leitet sich von der ursprünglichen aber falschen Vorstellung ab, dass die unterschiedliche Durchlässigkeit von Glas für Sonnen- und Wärmestrahlen die Erwärmung eines Gewächshauses verursacht. Ich verwende diesen (irreführenden) Begriff im Sinne von Gl. 1 & 2 weil er sich eingebürgert hat.

Die durch IR-Strahlung übertragbare netto Strahlungsleistung P (Power) ist demnach nicht nur von der Temperatur der warmen Erd-Platte TE, sondern auch von der Temperatur der kalten Aerosol-Platte TA abhängig. Die IR-Strahlung der kalten Platte vermindert die Wärmeübertragung P (wenn TA > 0)und kann auch als Gegenstrahlung (eigentliche Ursache des erdnaher Treibhauseffektes) bezeichnet werden.

Diese harmlos klingende These ist eine fundamentale Kritik der Klimahysterie. Die Aerosol-Platte simuliert die Strahlungen von Wolken/Aerosolen. Auch ohne Treibhausgase würden Wolken/Aerosole einen Basis-Treibhauseffekt erzeugen. Die Wirkung der Treibhausgase ist letztlich nur eine geringe Verstärkung dieser allgegenwärtigen Hintergrundstrahlung. Die elektrische Heizung der Erd-Platte (Wärmestromdichte Q/m2; im Folgenden nur als Heizung QE bezeichnet) und der Strahlungsverlust P sind gleich groß, da der warmen Erd-Platte genauso viel Energie (pro Zeiteinheit) zugeführt werden muss wie sie durch Strahlung verliert. Mechanische Wärmeströme werden durch die Konstruktion der Apparatur minimiert (Abb. 2) bzw. gehen als eine konstante Störung in einen Startwert ein.

Befindet sich zwischen Erd- und Aerosol-Platte ein IR-aktives Gas, kommt zur Gegenstrahlung der kalten Platte noch die Gegenstrahlung des IR-Gases hinzu. In der 3. Mitteilung wurde experimentell nachgewiesen, dass sich die Erd-Platte erwärmt, wenn bei konstanter Heizung QE IR-Gase zugesetzt werden [9]. Um die Strahlung der IR-Gase zu quantifizieren, wird nun nach jeder IR-Gas-Zugabe die Heizung QE für eine konstante Erd-Platten-Temperatur verringert. Aus den Veränderungen der Heizung QE werden die Emissionsgrade der IR-aktiven Gase berechnet. Allerdings muss zuvor noch die Strahlung der Seitenwand ermittelt werden, da sie die Wärmeübertragung beeinflusst. Hierzu wird vor Zugabe der IR-Gase die Heizung QE(0) als ein Startwert festgestellt und hieraus der Emissionsgrad der Seitenwand abgeleitet. Details zu diesen Rechnungen und Ableitungen sind in der 4. Mitteilung [7] ausführlich beschrieben, und eine Schritt für Schritt Anleitung befindet sich in Kap. 4. Der Treibhauseffekt der IR-Gase EGas(n) lässt sich für die Laborapparatur nach Gl. 2 berechnen. Dabei beschreibt EGas(n) die Bestrahlungsstärke der Erd-Platte in W/m2 durch ein IR-Gas mit der Vordergrund-Temperatur TV, der Hintergrund-Temperatur der Aerosol-Platte TH (beide in Kelvin) und einer Molmenge n (Anzahl der Mole).

εGas(n) sind die Emissionsgrade der unterschiedlichen IR-Gase, die nur noch von der Molmenge n abhängen (Abb. 1). Wird die Hintergrundstrahlung ignoriert (TH = 0), lässt sich mit Gl. 2 die theoretische Strahlung eines IR-aktiven Gases berechnen und bei TV = TH wird der Treibhauseffekt null.

Die Rechnungen beziehen sich auf die absolute Zahl der IR-Gas-Moleküle in einem wasserdampffreien Luftvolumen beliebiger Größe. Dabei wird vorausgesetzt, dass tatsächlich alle IR-Moleküle einen Beitrag zur Gegenstrahlung leisten. Bei sehr starken IR-Strahlern wie Freone/SF6 oder sehr langen Apparaturen könnte das problematisch sein, da hier schon nach einer gewissen Ausbreitungsstrecke (Volumentiefe) Sättigung eintritt. In diesen Fällen muss IR-Gas-Konzentration verringert werden.

In der Atmosphäre wird die Hintergrundstrahlung durch Wolken/Aerosole verursacht, wobei TH ihre Strahlungstemperatur ist. Da IR-Gase in der Regel eine höhere Temperatur als Wolken/Aerosole haben, führt ihre Anwesenheit zu einer Erhöhung der Gegenstrahlung (Gl. 2). Aber ob und wie sich dabei die Erd-Temperatur TE verändert ist eine ganz andere Frage, die von den örtlichen Gegebenheiten abhängt:

Bei einer warmen, trockenen Oberfläche (z.B. in einer Trockenwüste) würde CO2, besonders bei klarem Himmel, einen Anstieg der Erd-Temperatur TE verursachen, wie auch die Labor-Experimente gezeigt haben [9].

Wird auch die Luft durch den CO2-Treibhauseffekt erwärmt? Diese Frage ist nicht leicht zu beantworten und ist Gegenstand meiner aktuellen Untersuchungen. Wäre die CO2-Schicht sehr dünn und mittig in der Atmosphäre würde sich ihre Temperatur nicht ändern, denn die Schicht verliert Wärme (durch die CO2-Strahlung) aber gewinnt auch Wärme (durch die zusätzliche IR-Strahlung der erwärmten Erde). Der Treibhauseffekt würde unter solchen Bedingungen nur eine Erwärmung der Erde, aber nicht die der Luft bewirken! Nun ist CO2 aber keine dünne Schicht, sondern in der gesamten Atmosphäre vorhanden und zwar als ein Vermittler zwischen warmen und kalten Strahlern. Die Folge ist ein auf Strahlungsaustausch beruhender Temperatur-Gradient, wobei auf der warmen Seite (Erdnähe) die Temperatur ansteigt, auf der kalten Seite (Stratosphäre) aber sinkt. Letzteres ist m.E. im Bereich der CO2-Wellenlängen von Wettersatelliten (den sogenannten Ausstrahlungstrichtern bei den IR-Emissions-Spektren) bereits nachgewiesen. Bei der erdnahen Atmosphäre sollte sich der Gradient jedoch nicht bemerkbar machen, da hier die Temperaturen hauptsächlich von mechanischen Wärmeströmen, Luftdruck und Luftströmungen bestimmt werden.

Feuchtgebiete, Wälder oder Wasseroberflächen (⅔ der Erdoberfläche!) können auf die zusätzliche CO2-Strahlung mit verstärkter Verdunstung von Wasser reagieren und dadurch den Temperaturanstieg TE dämpfen. In diesen Fällen würde sich der Strahlungstransport P gemäß Gl. 1 verringern. Vermehrte Verdunstungswärme und Konvektion feuchter Luft könnten allerdings das Defizit ausgleichen. Dafür spricht, dass 60 % der Erdoberflächenwärme durch Evapotranspiration und nur 40 % durch Strahlung an die Atmosphäre abgeführt werden [10]. Sollte die zusätzliche Wasser-Verdunstung zu einem größeren Wolkenbedeckungsgrad führen, würde CO2 paradoxerweise sogar zu einer globalen Abkühlung wegen Zunahme der Wolkenalbedo beitragen (negative CO2-Wolken-Rückkopplung)!

In der kalten Antarktis, wo Luftschichten in großer Höhe wärmer als der Boden sein können, verursacht CO2, wie Satelliten festgestellt haben, eine Verstärkung der IR-Ausstrahlung an das Weltall, was zur Abkühlung des Südpols beiträgt.

Viele dieser angesprochenen Mechanismen scheinen mir z.Z. noch nicht ausreichend verstanden und untersucht. Angesichts dieser Komplexität bewerte ich die IR-Gase nur auf der Basis ihrer unbestreitbaren, messbaren IR-Strahlungen (in W/m2) und überlasse es zukünftigen Untersuchungen, hieraus eine Klimasensitivität (Temperaturanstieg in °C) abzuleiten.

Die Klimahysterie der Alarmisten beruht auf der Annahme, dass sich die Welt in einem sensiblen Gleichgewicht befindet, das durch kleinste Störungen unwiderruflich in eine Katastrophe mündet. Es zeigt sich jedoch, dass Systeme in Natur und Technik immer dann stabil und robust sind, wenn zu jeder Steuergröße ein Gegenspieler vorhanden ist (Sympathikus/Parasympathikus, Insulin/Glucagon, positive/negative Rückkopplung), wodurch ein Regelkreis entsteht. Schnelle und langfristige Regelkreise sollten auch auf der Erde existieren. Sie könnten eigenständig agieren oder sich mit planetaren Ursachen für Klimaschwankungen wie z.B. den Milankovitch‐Zyklen [11] überlagern. So ist auch ein langfristiger Wolkeneffekt als Antagonist zur Eisalbedo denkbar:

Bei einer Eiszeit verringern sich Wasserverdunstung und Aerosol-Konzentration (Wasserdampf-Kondensationskeime!) durch Vereisung von Wasseroberflächen und durch Eis-Ablagerung auf den Kontinenten. Die Folge sollte ein Rückgang der Wolkenschicht und eine zunehmend größere Sonnenbestrahlung der Erdoberfläche sein, wodurch der Eispanzer langsam wieder auftauen kann. Bei einer Warmzeit ist es genau umgekehrt. Durch die Zunahme der Wolken wird die Sonnenstrahlung stärker reflektiert und verhindert eine extreme Erwärmung. Es wäre wünschenswert, wenn Klimatologen nach solchen oder ähnlichen Regelkreisen suchen würden, die erklären, warum sich die Erd-Temperatur, trotz erheblicher Schwankungen, immer wieder „normalisiert“ hat, was einem sensiblen Gleichgewicht widerspricht und auf ein robustes Klima-System hinweist.

Die Strahlung der IR-Gase ist in allen Richtungen gleich groß. Deswegen wird nicht nur die Gegen- sondern auch die Ausstrahlung (in Richtung Aerosol-Platte) von den IR-Gasen beeinflusst. Tatsächlich ließ sich eine Zunahme der Ausstrahlung experimentell nachweisen (Kap. 4). Hierzu wurde die Thermoelektrizität Pt von Peltier-Elemente gemessen, die sich auf der Aerosol-Platte befinden(Abb. 2). Allerdings ist dieser Effekt nicht so eindeutig wie die Gegenstrahlung, die mit der Heizung QE nachgewiesen wird. In der Umgebung der Aerosol-Platte gibt es (anders als bei der Erd-Platte) einen großen Temperatur-Gradienten von 30 K zwischen Tp4 und TA, wodurch die Peltier-Elemente auch durch die Wärmeleitung der Gasphase beeinflusst werden. Für die These einer zusätzlichen IR-Strahlung durch IR-Gase spricht, dass bei allen Versuchen eine Zunahme der Pt-Spannung beobachtet wird. Das ist insofern bemerkenswert, da nur Methan eine höhere, die anderen IR-Gase aber eine kleinere spezifische Wärmeleitung als Luft haben, was hier eine Abnahme der Pt-Spannung verursachen müsste.

Eine Übertragung dieses Ausstrahlungs-Effektes auf die Erd-Atmosphäre ist nicht zulässig. Die Erd-Platte hat im Experiment (anders als die Erdoberfläche) nur einen kleinen Einfluss auf die Ausstrahlung.

Nach Gl. 2 verursachen IR-Gase einen Treibhauseffekt (Zunahme der Gegenstrahlung), wenn ihre Temperatur TV höher als die des Hintergrundes TH ist. Diese Aussage ist nur gültig, wenn sich beide Strahlungsquellen auf die gleiche Strahlungsfläche beziehen. Für die Gegenstrahlung trifft das zu, da Aerosol-Platte und Gasphase den gleichen Querschnitt haben und die Erd-Platte nur ein Sensor für die Gegenstrahlung ist. Im Falle der Ausstrahlung ist die Erd-Platte aber Strahlungsquelle, wobei Erd-Platte und Gasphase (fast) die gleiche Temperatur haben und der Ausstrahlungseffekt null sein sollte. Da die Gasphase aber eine größere Strahlungsfläche als die Erd-Platte hat, kommt es zu einer Zunahme der Ausstrahlung nach Zugabe von IR-Gasen.

Emissionsgrade der atmosphärischen Spurengas

Abbildung 3 zeigt die Emissionsgrade εGas(n) von Methan, CO2 und Lachgas im Molmengenbereich n von 0 bis 1 mol. Die Beziehung zwischen Emissionsgrad εGas und Molmenge n hat keinen einheitlichen Verlauf. Bei sehr kleinen Molmengen wird ein steiler, linearer Anstieg registriert, der bei größeren Mengen in eine logarithmische Progression übergeht. Bei noch größeren Molmengen tritt zusätzlich noch ein Konzentrationseffekt auf. Dieses komplexe Verhalten führt dazu, dass mit drei verschiedenen Formeln Y1, Y2 und Y3 die Beziehung zwischen Emissionsgrad εGas(n) und Molmenge n beschrieben werden. Zur besseren Übersicht werden die 3 Progressionskurven in den Farben Blau, Rot und Grün gezeichnet.

Formel Y1, der blaue Bereich bis 0,12 mol: Schon geringe Änderung der Molmenge führen zu einem starken, linearen Anstieg des Emissionsgrades εGas(n). Es wird vermutet, dass hier die IR-Strahlung hauptsächlich von der zentralen Vibrationsbande der IR-Gase, dem sogenannten Q-Zweig verursacht wird (Abb. 4). Da es sich um eine sehr starke Bande handelt, führt die Erhöhung der Molmenge schnell zu einer Sättigung [12].

Formel Y2, der rote Bereich bis 0,5 mol: Die weitere Zunahme der Emissionsgrade εGas(n) kann nur noch durch die wesentlich kleineren Rotationsbanden, den R- (abnehmend) und P-(zunehmend) Zweigen (branch), erfolgen (Abb. 4). Der rote Bereich und sein weiterer, theoretischer Verlauf gemäß Formel Y2 (schwarze Linie bis 1,0 mol) charakterisiert die maximal mögliche Strahlung der atmosphärischen Spurengase bei hohen Molmengen. Y2 ist somit die Rechenbasis für die CO2-Strahlungen. Auch die molaren Emissionsgrade εm für n = 1 mol werden mit Y2 berechnet (Tab. 1). Danach ist Methan ein deutlich schwächerer IR-Strahler als CO2.

Formel Y3, der grüne Bereich oberhalb von 1 Vol.-%: Ab einer Konzentration von 1 Vol.-% tritt ein sprunghafter Anstieg der Emissionsgrade εGas(n) auf, der die logarithmische Progression zu höheren Werten verschiebt. Dieser Konzentrations-Effekt wird auch in der IR-Spektroskopie beobachtet und wird dort als Bandenverbreiterung bezeichnet [13], [7]. Für die Beurteilung des atmosphärischen Treibhauseffektes spielt die Bandenverbreiterung keine Rolle, da die Atmosphären-Konzentrationen von Methan, CO2 und Lachgas viel kleiner als 1 Vol.-% (10.000 ppm) sind. Werden jedoch bei Labormessungen die IR-Gase bei Konzentrationen > 1 Vol.-% untersucht, werden unrealistisch hohe Werte erhalten, die nicht die Atmosphäre widerspiegeln, was (auch bei der Auswertung von HITRAN-Spektren) zu beachten ist.

Wasserdampf kann aus physikalischen Gründen (Gefrierpunkt = 0 °C) mit der Apparatur nicht untersucht werden. In der Atmosphäre führt Wasserdampf aufgrund seiner vielen Absorptionslinien und seiner sehr großen Menge (bis zu 100-mal größer als CO2) zu einem weiteren Wirkungsverlust der Spurengase. Eine 1:1 Übertragung der Labor-Experimente ist deshalb bestenfalls auf Trockenwüsten zulässig. Hierzu könnte man einwenden, dass mit der Apparatur nur die Emissionsgrade εGas(n) der IR-aktiven Gase ermitteln werden und eine Übertragung auf die Atmosphäre unzulässig ist. M.E. sollte es aber grundsätzlich möglich sein, aus diesen Laborergebnissen gewisse Rückschlüsse zu ziehen. Der Strahlungstransport P in der erdnahen Atmosphäre unterliegt den gleichen physikalischen Gesetzen von Vorder- und Hintergrundstrahlung und die Apparatur modelliert diese Mechanismen in einem bestimmten Maßstab (Kap. 3). Allerdings muss man sich auch den Einschränkungen bewusst sein, die beim Klima der Erde eine Rolle spielen, wie beispielsweise der erdferne Treibhauseffekt, der Druckgradient der Atmosphäre, die Erdrotation oder die bereits erwähnte Evapotranspiration, die von der Apparatur nicht nachgebildet werden.

Emissionsgrade der gesättigten Kohlenwasserstoffe

Da mir für die vorherigen Untersuchungen kein reines Methan zur Verfügung stand, wurde an seiner Stelle Erdgas eingesetzt. Der Gasversorger gibt im Sicherheitsdatenblatt einen Methangehalt von 80-99 % und als mögliche Verunreinigungen Ethan (0-12 %) und Propan (0-4 %) an. Man könnte nun argumentieren, dass der geringe molare Methan-Emissionsgrad εm möglicherweise durch die Verunreinigungen im Erdgas verursacht wird. Um diesem Einwand nachzugehen, wurden neben Methan auch noch Propan und nButan untersucht (Abb. 5). Diese drei Substanzen gehören derselben chemischen Familie, den Alkanen, an. Sie sind homologe Verbindungen, die sich nur durch weitere CH2-Gruppen unterscheiden und deshalb bei den Emissionsgraden εGas(n) einen Trend ergeben sollten.

Die gemessenen Emissionsgrade εGas(n) der drei Alkane zeigen erneut eine doppelte Abhängigkeit sowohl von der Molmenge n als auch von der Konzentration (Y1: Blau, Y2: Rot und Y3: Grün). Auffällig ist eine Verlängerung des blauen, linearen Y1-Bereiches, von 0,12 auf 0,23 mol. Eine größere Anzahl von Vibrationsschwingungen im Q-Zweig könnte hierfür die Ursache sein.

Die molaren Emissionsgrade εm wurden mit der Y2-Formel für n = 1 mol berechnet. Trägt man die εm Werte über die Anzahl der C-Atome auf, zeigt sich, dass die Strahlungsfähigkeit der Alkane von ihrer Kettenlänge abhängig ist: εm = 0,0367 ∙ ln(x)+0,0291 (x = Anzahl der C-Atome) (Abb. 6). Mit dieser Formel lässt sich auch der molare Emissionsgrad für das fehlende Ethan berechnen. Die Kurve zeigt eine logarithmische Progression, die Methan als den Strahler mit dem kleinesten molaren Emissionsgrad εm ausweist. Wenn also Erdgas mit Ethan/Propan verunreinigt sein sollte, wäre dadurch der molare Emissionsgrad εm des reinen Methans sogar noch etwas kleiner als 0,029.

Treibhauspotential – eine Mogelpackung?

Wikipedia: „Das (relative) Treibhauspotential (englisch: greenhouse warming potential, GWP) oder CO2-Äquivalent einer chemischen Verbindung ist eine Maßzahl für ihren relativen Beitrag zum Treibhauseffekt, also ihre mittlere Erwärmungswirkung der Erdatmosphäre über einen bestimmten Zeitraum (in der Regel 100 Jahre). Sie gibt damit an, wie viel eine bestimmte Masse eines Treibhausgases im Vergleich zur gleichen Menge CO2 zur globalen Erwärmung beiträgt. Beispielsweise beträgt das CO2-Äquivalent für Methan bei einem Zeithorizont von 100 Jahren 28: Das bedeutet, dass ein Kilogramm Methan innerhalb der ersten 100 Jahre nach der Freisetzung 28-mal so stark zum Treibhauseffekt beiträgt wie ein Kilogramm CO2. Bei Distickstoffmonoxid beträgt dieser Wert 265“ [14].

Wie bitte? Hatten wir nicht gerade die geringere Strahlungsfähigkeit des Methans im Vergleich zum CO2 festgestellt? Hat IPCC getrickst? Ja eindeutig! Das Treibhauspotential ist ein typisches Beispiel für einen Apfel- und Birnenvergleich. Zunächst zur Masseneinheit Kilogramm. Die IR-Strahlung eines Gases leitet sich nun mal von der der Molmenge (mol) und nicht vom Kilogramm ab. Ein Kilogramm CO2 (1000/44,01) entsprechen 22,7 mol CO2, während 1 kg Methan (1000/16,04) 62,3 mol sind, also 2,7-mal mehr als beim CO2. Das ist allerdings nur ein kleiner Trick, der auch nur beim Methan richtig funktioniert. Der eigentliche Trick ist, dass die Emissionsgrade εGas(n) Variablen sind, die extrem von ihren Molmengen n abhängen, wie in allen gezeigten Grafiken zu sehen ist. Das atmosphärische CO2 beendet bereits bei rund 100 ppm den steilen Y1 Anstieg und folgt nun einer flachen logarithmischen Weiterentwicklung im „roten“ Y2-Bereich [15]. Demgegenüber verbleiben Methan (1,8 ppm) und Lachgas (0,3 ppm) im „blauen“ Y1 Bereich, mit relativ großen Strahlungszunahmen bei geringen Mol-Änderungen. Die Strahlungen der Spurengasen folgen also völlig unterschiedlichen Gesetzen (Y1 vs. Y2). Ein Apfel- und Birnen- Vergleich ist nicht Wissenschaft, sondern Populismus und Panikmache wie folgende Überschlagsrechnungen zeigen.

Der für die Strahlung maßgebliche Emissionsgrad εGas(n) hängt von der Anzahl der IR-Gas-Moleküle n unter einer Wolkenschicht ab und ist bei Methan/Lachgas sehr viel kleiner als beim CO2. Tab. 4 zeigt die Strahlungsanstieg von Methan, Lachgas und CO2 von 1750 bis 2018.

Die Berechnung der atmosphärischen CO2-Strahlung wurde bereits in der 4. Mitteilung vorgestellt [7]. Es stellte sich heraus, dass Luftschichten oberhalb von 1.000 m den CO2-Treibhauseffekt nicht mehr erhöhen. Diese Grenze wurde nun aus Vergleichsgründen für alle Spurengase zugrunde gelegt. Die Rechnungen erfolgen in drei Schritten:

Im ersten Schritt wird die Molmenge n aus der IR-Gas-Konzentration errechnet wie in Kap. 4 angegeben. Aus der Molmenge n werden die Emissionsgarde εGas(n) gemäß Tab. 3 ermittelt. Dabei werden für Methan und Lachgas die Y1-Formeln und für CO2, wegen seinen hohen Konzentration, die Y2-Formel verwendet. Mit Gl. 2 wird dann die Gegenstrahlung EGas(n) der einzelnen Spurengase berechnet.

Diese Rechnungen sind aus verschiedenen Gründen nur grobe Näherungen: So wurde die Hintergrund-Temperatur TH der Wolken/Aerosole nur geschätzt, für die Vordergrund-Temperatur TV Durchschnittswerte verwendet und die Wasserdampf-Strahlung nicht berücksichtigt. Die gefundenen Strahlungswerte EGas(n) können somit nach oben oder unten von den tatsächlichen Werten abweichen. Dennoch wurden mit diesen sehr einfachen Rechnungen erstaunliche gute Übereinstimmungen mit Strahlungstransfer-Rechnungen erzielt, die H. Harde [16] mit modifizierten Schwarzschild-Gleichungen durchgeführt hatte und die zu folgenden Kernaussagen führten:

„Kontinuierliche Prozesse wandeln in der Atmosphäre Wärme in Strahlung und Strahlung in Wärme um. CO2 allein könnte 24,1 % der IR-Strahlung der Erde absorbieren. In Gegenwart anderer IR-Gase, hauptsächlich Wasserdampf, verringert sich dieser Wert auf 4,6 %. Die zentrale CO2-Absorptionsbande ist bereits nach 1 m Ausbreitungslänge gesättigt und eine weitere Absorptionszunahme durch R- und P-Seitenbänder endet bei rund 1 km. Bei klarem Himmel würde eine Verdopplung von CO2 die Gesamtabsorption um 1,2 % erhöhen, aber unter Wolken wird der CO2-Beitrag unter 1 % gesenkt.“

Eine weitere Übereinstimmung findet sich in einer vereinfachten IPCC-Formel, die für CO2 (400 ppm) eine Strahlungsdichte von 32,1 W/m2 errechnet. Dieser Wert stimmt sehr gut mit 30,7 W/m2 überein, wenn die CO2-Strahlung nach Gl. 2 ohne Hintergrundstrahlung (TH = 0) ermittelt wird [7].

Die guten Übereinstimmungen sind eine gegenseitige Bestätigung von theoretischen Berechnungen und experimentell gefunden Werten und sie erhärten den Verdacht, dass das IPCC von zu großen CO2-Strahlungswerten ausgeht und die Wirkungen von Wasserdampf und Wolken/Aerosole vernachlässigt.

Beim Lachgas (N2O) lässt sich kaum eine Veränderung von EN2O(n) ablesen, womit sich eine weitere Diskussion erübrigt. Die Methanstrahlung ECH4 erhöhte sich um 0,40 W/m2 (Faktor 2,3), während die CO2-Strahlung ECO2 um 0,55 W/m2 (Faktor 1,07) zunahm. Mit dem Trick der leichten Vervielfachung kleiner Zahlen lässt sich jetzt trefflich ein hohes Methan-Treibhauspotential postulieren. Geht man aber zu den absoluten Zahlen über, erzeugen Methan und Lachgas zusammen 1 W/m2, das ist nur ein Bruchteil der CO2-Strahlung von 9,5 W/m2. Und wenn man jetzt noch die gesamte atmosphärische Gegenstrahlung von 333 W/m2 [10] zugrunde legt, ist die Summe aller drei Spurengase mit rund 11 W/m2 nur ein Zwerg innerhalb der erdnahen IR-Strahlungen. Da sollte schon die Frage erlaubt sein, welchen Einfluss die restlichen 322 W/m2 haben, die durch Wolken, Wasserdampf und Aerosole verursacht werden und wie sich ihr Anteil seit 1750 entwickelt hat?

Nun gut, Kleinvieh macht auch Mist, und so könnte der CO2-Anstieg sogar ein Glücksfall für die Menschheit sein. Eiszeiten sind unvermeidlich und die nächste sogar überfällig. Bei der letzten Vereisung sank die CO2-Konzentration auf 180 ppm, nur 30 ppm von Ernährungsnot bzw. Erstickungstod der Pflanzenwelt entfernt und das wäre dann wirklich das Ende, wenn man P. Moore und J. Lovelock glauben mag [17]:

„Vor 140 Millionen Jahren hatte die Erde noch eine CO2-Konzentration von 2.500 ppm. Offensichtlich war diese Konzentration kein Nachteil und erst recht keine Katastrophe, denn es gab eine üppige Flora und die größten jemals auf der Erde lebenden Landtieren. Seitdem hat sich die CO2-Konzentration kontinuierlich verringert, hauptsächlich durch die Bildung von Kalkstein und Kreide (CaCO3) und hat vor 18.000 Jahren das o.g. Minimum erreicht. Anschließend haben Erd-Erwärmung und industrielle Revolution die CO2-Konzentration wieder auf 400 ppm erhöht. So können sich die Pflanzen heute über 850 Gt Kohlenstoff in der Atmosphäre freuen, aber die ferne Zukunft ist düster. Planktonische Muscheln, Korallen und Schalentiere wandeln zwar langsam aber unaufhörlich CO2 in CaCO3 um, ein Nettoverlust von 14.000 Gt Kohlenstoff in den letzten 550 Millionen Jahren. Wie lässt sich dieser lebensgefährdende Trend aufhalten? Vulkanismus als wichtigste CO2-Quelle in der Vergangenheit verliert zunehmend an Bedeutung und die fossilen Brennstoffe sind nun mal endlich. Langfristig wäre demnach CO2-Mangel und nicht der geringe CO2-Treibhauseffekt eine Bedrohung. So gesehen sind Energiewende und ‚Fridays For Future‘ der falsche Weg“.

Und was passiert mit dem Methan in der Atmosphäre? Nun es wird unter dem Einfluss von Sonnenlicht und Sauerstoff zu CO2 oxidiert und hat nach Wikipedia eine sehr kurze Verweildauer von 9–15 Jahren [1]. Ich kann nicht beurteilen, ob diese Angabe korrekt ist oder genauso falsch wie die CO2-Verweildauer, die vom IPCC mit 50-200 Jahren angegeben wird (oder sogar tausendende von Jahren nach S. Solomon) [18]. Die CO2-Verweildauer leitet sich von einem dynamischen System, dem Kohlenstoffzyklus ab. Dabei sind die Geschwindigkeiten der CO2-Freisetzung (Emission) und der CO2-Senkung (Absorption) die entscheidenden Kriterien. Die Verweildauer ist ein zentraler Punkt der Klimahysterie und soll vor Beginn der industriellen Entwicklung 3 Jahre betragen haben. In dieser Zeit sollen Emissions- und Absorptions-Geschwindigkeit gleich groß gewesen sein. Es wird nun angenommen, dass der CO2-Anstieg seit 1750 fast ausschließlich anthropogenen Ursprungs sei und die Senkung dieses zusätzlichen CO2 viel langsamer verläuft als im sogenannten natürlichen Kreislauf. H. Harde widerspricht der Hypothese der ungleichen Geschwindigkeiten und geht von einem leichten Anstieg der Verweildauer (4 Jahre) aus [19]. Seine Thesen und nachvollziehbaren Rechnungen stützen sich auf der Annahme, dass nicht der Mensch sondern die Erd-Temperatur die Geschwindigkeit beider Prozesse, Emission und Absorption, mit nur leicht unterschiedlichen Koeffizienten beeinflusst. Und auch der anthropogene Anteil an der CO2-Erhöhung ist mit 15 % (17 ppm von 113 ppm seit 1750) deutlich geringer als vom IPCC angenommen.

Die angeblich lange IPCC-CO2-Verweildauer ist allerdings ein Eigentor, denn dadurch ist die Methan-Verweildauer von nur 9-15 Jahren kein zusätzliches Argument für eine Klimagefährdung durch Methan.

Experimentelle Daten

Vor Durchführung eines Experimentes wird die Innenluft der Apparatur 24 Stunden über feste Natronlauge mit einer Geschwindigkeit von 1 l/min zur Entfernung von Wasserdampf und CO2 geleitet. Aus Sicherheitsgründen (Erhöhen der unteren Explosionsgrenze) wird im Falle von Propan und nButan der Sauerstoffgehalt durch Zumischung von 30 % Argon auf rund 14 % gesenkt. Nach jeder Zugabe eines IR-aktiven Gases wird die Spannung für die Heizfolie unter der Erd-Platte (Abb. 2) solange verringert, bis die Start-Temperatur der Erd-Platte von 16,09 °C gerade wieder erreicht ist. Da das System von Heizung und Temperatur-Messung eine gewisse Trägheit besitzt, wird das Mittel von zwei Messungen im Abstand von 0,01 bis 0,02 Volt gebildet, die beide 16,09 °C ergeben. Die Versuche wurden 2 bis 5-mal wiederholt und als Durchschnitt ausgewertet.

Die Erd-Platte hat einen Durchmesser von 16,7 cm und eine Fläche AE= 219,04 cm2. Zur Ermittlung der Wärmestromdichte QE wird die gemessene Stromleistung (Spannung mal Stromstärke) durch Multiplikation mit 45,654 auf einen Quadratmeter umgerechnet. Der Abstand zwischen Erd- und Aerosol-Platte beträgt 1,11 m. Die Rechnungen beziehen sich auf ein fiktives Luft-Volumen der Apparatur von 1,11 m3. Die Molmenge n wird aus der allgemeinen Gasgleichung n = p∙V/R∙TLuft abgeleitet. Dabei ist p der Luftdruck in hPa, R ist die Gaskonstante (8,31448 J/mol∙K), V ist der Volumenanteil des IR-Gases am fiktiven Volumen von 1,11 m3 in Liter (aus der Konzentration Vol.-%) und TLuft ist die Durchschnitts-Temperatur der Luftschicht von Tp1-Tp4 in Kelvin.

Im ersten Schritt wird die theoretische Wärmeübertragung E zwischen Erd- und Aerosol-Platte analog zu Gl. 1 ETheo = σ ∙ A ∙ (TE4-TA4) als Schwarzkörper-Strahlung berechnet (σ = 5,670367∙10-8 W/(m2 ∙ K4), A = 1 m2, T = Temperatur in Kelvin). Die Gegenstrahlung wird gemeinsam von Aerosol-Platte und Seitenwand erzeugt. Das Verhältnis von QE(0)/ETheo = εA(0) ist der effektive Emissionsgrad der Aerosol-Platte (sein Anteil an der Gegenstrahlung) ohne IR-Gase. Mit diesem ersten Messwert wird nach εW =1- εA(0) der Emissionsgrad der Seitenwand εW als eine Art Tageswert bestimmt. Nach der gleichen Prozedur wird nach jeder Zugabe des IR-Gases aus dem Verhältnis QE(n)/ETheo = εA(n) und εW+Gas =1- εA(n)der gemeinsame Emissionsgrad von Wand + IR-Gas errechnet und hiervon εW als eine Konstante abgezogen, wodurch εGas(n) erhalten wird.

Mit der Abkürzung Pt(n) wird die Spannung von 5 in Reihe geschalteten Peltier-Elementen angegeben. Während sich die Heizung QE(0) sehr gut reproduzieren lässt, unterliegt die Spannungsmessung Pt(0) einer stärker abweichenden Tagesform. Allerdings zeigt sich innerhalb einer Messung stets ein stetiger Anstieg der Pt(n) Werte ohne „Ausreißer“.

Methan Emissionsgrade

CO2 Emissionsgrade

Lachgas Emissionsgrade

Propan Emissionsgrade

Butan Emissionsgrade

Literaturverzeichnis

|

[1] |

„Methan,“ 15 März 2019. [Online]. Available: https://de.wikipedia.org/wiki/Methan . |

|

[2] |

„Distickstoffmonoxid,“ 9 April 2019. [Online]. Available: https://de.wikipedia.org/wiki/Distickstoffmonoxid . |

|

[3] |

„Emissionsgrad,“ 27 Juni 2018. [Online]. Available: https://de.wikipedia.org/wiki/Emissionsgrad . |

|

[4] |

„Emissionsgradtabelle,“ [Online]. Available: https://static-int.testo.com/media/b5/14/6481a245e502/Emissivity-table-DE.pdf . |

|

[5] |

„Gasstrahlung,“ 15 Oktober 2018. [Online]. Available: https://de.wikipedia.org/wiki/Gasstrahlung . |

|

[6] |

„Rayleigh-Streuung,“ März 20 2019. [Online]. Available: https://de.wikipedia.org/wiki/Rayleigh-Streuung . |

|

[7] |

M. Schnell, „Die erdnahe CO2-Strahlung,“ 27 Jan. 2019. [Online]. Available: https://www.eike-klima-energie.eu/2019/01/27/experimentelle-verifikation-des-treibhauseffektes-4-mitteilung-die-erdnahe-co2-strahlung/ . |

|

[8] |

„Strahlungsaustausch,“ 05 Aug. 2018. [Online]. Available: https://de.wikipedia.org/wiki/Strahlungsaustausch . |

|

[9] |

M. Schnell, „ Labor-Experimente zur Demonstration des CO2-Treibhauseffektes,“ 17 Juli 2018. [Online]. Available: https://www.eike-klima-energie.eu/2018/07/17/experimentelle-verifikation-des-treibhauseffektes-2/ . |

|

[10] |

K. Trenberth et al., „EARTH’S GLOBAL ENERGY BUDGET,“ 19 Juli 2008. [Online]. Available: https://www.klimamanifest-von-heiligenroth.de/wp/wp-content/uploads/2016/09/Trenberth_Jones_Treibhauseffekt_TFK_bams_2009_15Grad_390Watt_SBG_gelbMark.pdf . |

|

[11] |

„Milanković-Zyklen,“ 13 04 2019. [Online]. Available: https://de.wikipedia.org/wiki/Milankovi%C4%87-Zyklen . |

|

[12] |

H. Hug, „Der anthropogene Treibhauseffekt – eine spektroskopische Geringfügigkeit,“ 20 August 2012. [Online]. Available: https://www.eike-klima-energie.eu/2012/08/20/der-anthropogene-treibhauseffekt-eine-spektroskopische-geringfuegigkeit/ . |

|

[13] |

H. Harde et al., „Lineshape Transition of Collision Broadened Lines,“ Physical Review Letters, pp. 1308-1310, 20 Feb. 1995. |

|

[14] |

„Treibhauspotential,“ 4 April 2019. [Online]. Available: https://de.wikipedia.org/wiki/Treibhauspotential . |

|

[15] |

M. Schnell, „Experimentelle Verifizierung des Treibhauseffektes,“ 12. Internationale Klima- und Energiekonferenz (IKEK-12), München, 2018. |

|

[16] |

H. Harde, „Radiation and Heat Transfer in the Atmosphere: A Comprehensive Approach on a Molecular Basis,“ 2013. [Online]. Available: http://dx.doi.org/10.1155/2013/503727 . |

|

[17] |

P. Moore, „Die positiven Auswirkungen der menschlichen CO2-Emissionen,“ 12 06 2019. [Online]. Available: https://www.eike-klima-energie.eu/2019/06/12/die-positiven-auswirkungen-der-menschlichen-co2-emissionen-auf-das-ueberleben-des-lebens-auf-der-erde/ . |

|

[18] |

„Verweildauer von CO2: Henne oder Ei?,“ 3 Dez. 2013. [Online]. Available: https://www.eike-klima-energie.eu/2013/12/03/zur-verweildauer-von-co2-henne-oder-ei/ . |

|

[19] |

H. Harde, „What Humans Contribute to Atmospheric CO2: Comparison of Carbon Cycle Models with Observations,“ Earth Sciences, Bd. 8/3, pp. 139-159, 2019. |

Chris Frey | 28. Juni 2019 um 18:00 | Tags: CO2, Treibhauseffekt | URL: https://wp.me/p8dtMx-eRL

90 italienische Wissenschaftler unterzeichnen Petition gegen Klimaalarm |

Ja, in Italien haben vor kurzem über 90 Wissenschaftler eine Petition unterzeichnet mit dem Titel: “Klima, eine Gegenstrom-Petition“:

————

An den Präsidenten der Republik

An den Präsidenten des Senats

An den Präsidenten der Abgeordnetenkammer

An den Präsidenten des Rats

19.6.2019

PETITION ZUR GLOBALEN ANTHROPOGENEN ERWÄRMUNG

Die Unterzeichnenden, Bürger und Wissenschaftler, schicken eine warme Einladung an die politischen Führungskräfte, eine Umweltschutzpolitik einzuführen, welche im Einklang mit den wissenschaftlichen Erkenntnissen steht.

Insbesondere ist es dringend, die Verschmutzung dort zu bekämpfen, wo sie auftritt, gemäß den Befunden der modernsten Wissenschaft. Diesbezüglich ist die Verzögerung beklagenswert, mit welcher der Wissensreichtum, der von der Welt der Forschung zur Verfügung gestellt wird, benutzt wird, um die anthropogenen Schadstoffemissionen zu reduzieren, welche sowohl in den kontinentalen als auch Meeresumweltsystemen weit verbreitet vorhanden sind.

Aber uns muss bewusst sein, dass KOHLENDIOXID SELBST KEIN SCHADSTOFF IST. Im Gegenteil. Es ist für das Leben auf unserem Planeten unentbehrlich.

In den letzten Jahrzehnten hat sich eine These verbreitet, dass die Erwärmung der Erdoberfläche um rund 0,9°C, welche ab 1850 beobachtet worden ist, anomal wäre und ausschließlich von menschlichen Aktivitäten verursacht werden würde, insbesondere durch den Ausstoß von CO2 in die Atmosphäre beim Gebrauch fossiler Brennstoffe.

Dies ist die These der anthropogenen globalen Erwärmung, welche von dem Weltklimarat (IPCC) der Vereinten Nationen gefördert wird, deren Konsequenzen Umweltveränderungen sein würden, die so ernst wären, dass man enormen Schaden in der unmittelbaren Zukunft fürchten muss, außer wenn drastische und kostenintensive Abschwächungsmaßnahmen unverzüglich ergriffen werden.

Diesbezüglich sind viele Nationen in der Welt Programmen beigetreten, um Kohlendioxidemissionen zu reduzieren, und werden unter Druck gesetzt, auch durch eine nicht nachlassende Propaganda, zunehmend fordernde Programme anzunehmen, deren Umsetzung, welche mit hohen Belastungen auf die Wirtschaften der einzelnen Mitgliedsstaaten verbunden ist, von Klimakontrolle abhängig wäre und daher die „Rettung“ des Planeten.

Jedoch ist der anthropogene Ursprung der globalen Erwärmung EINE UNBEWIESENE HYPOTHESE, nur abgeleitet von einigen Klimamodellen, d.h. komplexen Computerprogrammen, genannt ‚General Circulation Models‘.

Hingegen hat die wissenschaftliche Literatur zunehmend die Existenz einer natürlichen Klimaschwankung betont, welche die Modelle nicht reproduzieren können.

Diese natürliche Schwankung erklärt einen beachtlichen Teil der globalen Erwärmung, welche seit 1850 beobachtet worden ist. Die anthropogene Verantwortung für die Klimaveränderung, welche in dem letzten Jahrhundert beobachtet worden ist, wird daher UNGERECHTFERTIGT ÜBERTRIEBEN und Katastrophenvorhersagen SIND NICHT REALISTISCH.

Das Klima ist das komplexeste System auf unseren Planeten, daher muss man sich damit mit Methoden befassen, welche adäquat sind und mit seinem Niveau der Komplexität übereinstimmen.

Klimasimulationsmodelle reproduzieren nicht die beobachtete natürliche Schwankung des Klimas und rekonstruieren insbesondere nicht die warmen Perioden der letzten 10.000 Jahre. Diese haben sich ungefähr alle tausend Jahre wiederholt und schließen die gut bekannte mittelalterliche Warmzeit ein, die heiße römische Periode, und generell die Warmzeiten während des „Holozänen Optimums“.

Die PERIODEN DER VERGANGENHEIT SIND AUCH WÄRMER GEWESEN ALS DIE GEGENWÄRTIGE ZEIT, obwohl die CO2 Konzentration niedriger war als die gegenwärtige, dieweil sie mit den tausendjährigen Zyklen der Sonnenaktivität verbunden sind. Die Auswirkungen werden von den Modellen nicht reproduziert.

Es sollte daran gedacht werden, dass die Erwärmung, welche seit 1900 beobachtet worden ist, tatsächlich in den 1700en begann, d.h. am Tiefpunkt der Kleinen Eiszeit, der kältesten Periode der letzten 10.000 Jahre (übereinstimmend mit dem tausendjährigen Tiefpunkt der Sonnenaktivität, welche Astrophysiker Maunder Minimum nennen). Seitdem ist die Sonnenaktivität, ihrem tausendjährigen Zyklus folgend, angestiegen, wobei sie die Erdoberfläche erwärmt.

Des Weiteren versagen die Modelle dabei, die bekannten Klimaschwankungen von ungefähr 60 Jahren zu reproduzieren.

Diese waren zum Beispiel verantwortlich für eine Warmzeit (1850-1880) gefolgt von einer kühleren Periode (1880-1910), eine Erwärmung (1910-40), eine Abkühlung (1940-70) und einer neuen wärmeren Periode (1970-2000) ähnlich der, welche 60 Jahre früher beobachtet wurde.

Die folgenden Jahre (2000-2019) sahen einen Anstieg, der nicht von den Modellen vorhergesagt wurde, von ungefähr 0,2°C pro Jahrzehnt, und eine beachtliche Klimastabilität, welche sporadisch von den schnellen natürlichen Schwankungen des äquatorialen Pazifischen Ozeans unterbrochen wurde, bekannt als die El Nino Southern Oscillations, wie diejenige, welche zu der temporären Erwärmung zwischen 2015 und 2016 führte.

Die Medien behaupten auch, dass extreme Ereignisse, wie z.B. Hurrikans und Zyklone, alarmierend angestiegen sind. Umgekehrt sind diese Ereignisse, wie viele Klimasysteme, seit dem zuvor erwähnten 60-Jahre-Zyklus moduliert worden.

Zum Beispiel, wenn wir die offiziellen Daten von 1880 über tropische Atlantikzyklone betrachten, welche Nordamerika getroffen haben, scheinen sie eine starke 60-Jahre Schwankung zu haben, entsprechend der thermischen Schwankung des Atlantiks, genannt Atlantic Multidecadal Oscillation (=atlantische mehrdekadische Schwankung).

Die Spitzen, welche pro Jahrzehnt beobachtet wurden, sind in den Jahren 1880-90, 1940-50 und 1995-2005 miteinander kompatibel. Von 2005 bis 2015 nahm die Anzahl der Zyklone ab, wobei dies präzise dem zuvor erwähnten Zyklus folgte. Somit gibt es in der Zeitspanne von 1880-2015 zwischen der Anzahl der Zyklone (welche schwanken) und dem CO2 (welches monoton ansteigt) keine Korrelation.

Das Klimasystem wird noch nicht ausreichend verstanden. Obwohl es wahr ist, dass CO2 ein Treibhausgas ist, ist laut dem IPCC die Klimasensitivität auf dessen Anstieg in der Atmosphäre immer noch extrem unsicher.

Es wird geschätzt, dass eine Verdoppelung der Konzentration des atmosphärischen CO2 von ungefähr 300ppm vorindustriell auf 600ppm die Durchschnittstemperatur des Planeten von einem Minimum von 1°C bis zu einem Maximum von 5°C erhöhen kann.

Diese Unsicherheit ist enorm.

Jedenfalls schätzen viele neue Studien, die auf experimentellen Daten basieren, dass die Klimasensitivität auf CO2 BEDEUTEND NIEDRIGER ist als jene, die von den IPCC Modellen geschätzt wird.

Dann ist es wissenschaftlich unrealistisch, die Verantwortung für die Erwärmung, welche vom vergangenen Jahrhundert bis heute beobachtet wurde, den Menschen zuzuschreiben. Die voreilenden Vorhersagen der Panikmacher sind daher nicht glaubwürdig, da sie auf Modellen basieren, deren Ergebnisse den experimentellen Daten wiedersprechen.

Alle Beweise legen nahe, dass diese MODELLE den anthropogenen Beitrag ÜBERSCHÄTZEN und die natürliche Klimaschwankung unterschätzen, besonders jene, die von der Sonne, dem Mond und den Meeresschwankungen verursacht wird.

Schließlich veröffentlichen die Medien die Nachricht, laut dessen es in Bezug auf die menschliche Ursache der gegenwärtigen Klimaänderung einen fast einstimmigen Konsens unter den Wissenschaftlern gibt, dass die wissenschaftliche Debatte abgeschlossen werden würde.

Jedoch müssen wir uns zuerst einmal bewusst werden, dass die wissenschaftliche Methode bestimmt, dass die Fakten und nicht die Anzahl der Anhänger eine Mutmaßung zu einer gemeinsamen wissenschaftlichen Theorie machen.

Wie dem auch sei, der gleiche angebliche Konsens EXISTIERT NICHT. Es gibt tatsächlich eine bemerkenswerte Variabilität an Meinungen unter den Spezialisten – Klimatologen, Meteorologen, Geologen, Geophysiker, Astrophysiker – von denen viele einen wichtigen natürlichen Beitrag zur globalen Erwärmung anerkennen, welche von der vorindustriellen Zeit und sogar von der Vorkriegszeit bis heute beobachtet worden ist.

Es hat auch Petitionen gegeben, welche von tausenden von Wissenschaftlern unterschrieben worden sind, die eine abweichende Meinung zur Mutmaßung der anthropogenen globalen Erwärmung ausgedrückt haben.

Diese umfassen diejenige, welche 2007 von dem Physiker F. Seitz gefördert wurde, ehemaliger Präsident der American National Academy of Science, und diejenige, welche von dem nichtstaatlichen Weltklimarat (NIPCC) gefördert wurde, deren Bericht von 2009 zu dem Schluss kommt, dass „die Natur, und nicht die Aktivität des Menschen, regiert das Klima“.

Zum Schluss, angesichts der ENTSCHEIDENDEN WICHTIGKEIT, WELCHE FOSSILE TREIBSTOFFE für die Energieversorgung der Menschheit haben, schlagen wir vor, dass sie nicht der Politik von kritikloser Reduzierung der Emission von Kohlendioxid in die Atmosphäre unterworfen werden sollten mit DEM ILLUSORISCHEN ANSCHEIN DES BEHERRSCHENS DES KLIMAS.

FÖRDERKOMITEE :

1. Uberto Crescenti, Emeritus Professor of Applied Geology, University G. D’Annunzio, Chieti-Pescara, formerly Rector and President of the Italian Geological Society.

2. Giuliano Panza, Professor of Seismology, University of Trieste, Academician of the Lincei and of the National Academy of Sciences, called of the XL, 2018 International Award of the American Geophysical Union.

3. Alberto Prestininzi, Professor of Applied Geology, La Sapienza University, Rome, formerly Scientific Editor in Chief of the magazine International IJEGE and Director of the Geological Risk Forecasting and Control Research Center.

4. Franco Prodi, Professor of Atmospheric Physics, University of Ferrara.

5. Franco Battaglia, Professor of Physical Chemistry, University of Modena; Galileo Movement 2001.

6. Mario Giaccio, Professor of Technology and Economics of Energy Sources, University G. D’Annunzio, Chieti-Pescara, former Dean of the Faculty of Economics.

7. Enrico Miccadei, Professor of Physical Geography and Geomorphology, University G. D’Annunzio, Chieti-Pescara.

8. Nicola Scafetta, Professor of Atmospheric Physics and Oceanography, Federico II University, Naples.

UNTERZEICHNENDE

1. Antonino Zichichi, Emeritus Professor of Physics, University of Bologna, Founder and President of the Ettore Center for Scientific Culture Majorana di Erice.

2. Renato Angelo Ricci, Professor Emeritus of Physics, University of Padua, former President of the Italian Society of Physics and Society European Physics; Galileo Movement 2001.

3. Aurelio Misiti, Professor of Health-Environmental Engineering, University of Sapienza, Rome.

4. Antonio Brambati, Professor of Sedimentology, University of Trieste, Project Manager Paleoclima-mare of PNRA, already President of the National Oceanography Commission.

5. Cesare Barbieri, Professor Emeritus of Astronomy, University of Padua.

6. Sergio Bartalucci, Physicist, President of the Association of Scientists and Tecnolgi for Italian Research.

7. Antonio Bianchini, Professor of Astronomy, University of Padua.

8. Paolo Bonifazi, former Director of the Institute of Interplanetary Space Physics, National Astrophysical Institute.

9. Francesca Bozzano, Professor of Applied Geology, Sapienza University of Rome, Director of the CERI Research Center.

10. Marcello Buccolini, Professor of Geomorphology, University University G. D’Annunzio, Chieti-Pescara.

11. Paolo Budetta, Professor of Applied Geology, University of Naples.

12. Monia Calista, Researcher in Applied Geology, University G. D’Annunzio, Chieti-Pescara.

13. Giovanni Carboni, Professor of Physics, Tor Vergata University, Rome; Galileo Movement 2001.

14. Franco Casali, Professor of Physics, University of Bologna and Bologna Academy of Sciences.

15. Giuliano Ceradelli, Engineer and climatologist, ALDAI.

16. Domenico Corradini, Professor of Historical Geology, University of Modena.

17. Fulvio Crisciani, Professor of Geophysical Fluid Dynamics, University of Trieste and Marine Sciences Institute, Cnr, Trieste.

18. Carlo Esposito, Professor of Remote Sensing, La Sapienza University, Rome.

19. Mario Floris, Professor of Remote Sensing, University of Padua.

20. Gianni Fochi, Chemist, Scuola Normale Superiore of Pisa; scientific journalist.

21. Mario Gaeta, Professor of Volcanology, La Sapienza University, Rome.

22. Giuseppe Gambolati, Fellow of the American Geophysica Union, Professor of Numerical Methods, University of Padua.

23. Rinaldo Genevois, Professor of Applied Geology, University of Padua.

24. Carlo Lombardi, Professor of Nuclear Plants, Milan Polytechnic.

25. Luigi Marino, Geologist, Geological Risk Forecasting and Control Research Center, La Sapienza University, Rome.

26. Salvatore Martino, Professor of Seismic Microzonation, La Sapienza University, Rome.

27. Paolo Mazzanti, Professor of Satellite Interferometry, La Sapienza University, Rome.

28. Adriano Mazzarella, Professor of Meteorology and Climatology, University of Naples.

29. Carlo Merli, Professor of Environmental Technologies, La Sapienza University, Rome.

30. Alberto Mirandola, Professor of Applied Energetics and President of the Research Doctorate in Energy, University of Padua.

31. Renzo Mosetti, Professor of Oceanography, University of Trieste, former Director of the Department of Oceanography, Istituto OGS, Trieste.

32. Daniela Novembre, Researcher in Mining Geological Resources and Mineralogical Applications, University G. D’Annunzio, Chieti Pescara.

33. Sergio Ortolani, Professor of Astronomy and Astrophysics, University of Padua.

34. Antonio Pasculli, Researcher of Applied Geology, University G. D’Annunzio, Chieti-Pescara.

35. Ernesto Pedrocchi, Professor Emeritus of Energetics, Polytechnic of Milan.

36. Tommaso Piacentini, Professor of Physical Geography and Geomorphology, University G. D’Annunzio, Chieti-Pescara.

37. Guido Possa, nuclear engineer, formerly Deputy Minister Miur.

38. Mario Luigi Rainone, Professor of Applied Geology, University of Chieti-Pescara.

39. Francesca Quercia, Geologist, Research Director, Ispra.

40. Giancarlo Ruocco, Professor of Structure of Matter, La Sapienza University, Rome.

41. Sergio Rusi, Professor of Hydrogeology, University G. D’Annunzio, Chieti-Pescara.

42. Massimo Salleolini, Professor of Applied Hydrogeology and Environmental Hydrology, University of Siena.

43. Emanuele Scalcione, Head of Regional Agrometeorological Service Alsia, Basilicata.

44. Nicola Sciarra, Professor of Applied Geology, University G. D’Annunzio, Chieti-Pescara.

45. Leonello Serva, Geologist, Director of Geological Services of Italy; Galileo Movement 2001.

46. Luigi Stedile, Geologist, Geological Risk Review and Control Research Center, La Sapienza University, Rome.

47. Giorgio Trenta, Physicist and Physician, President Emeritus of the Italian Association of Medical Radiation Protection; Galileo Movement 2001.

48. Gianluca Valenzise, Director of Research, National Institute of Geophysics and Volcanology, Rome.

49. Corrado Venturini, Professor of Structural Geology, University of Bologna.

50. Franco Zavatti, Astronomy Researcher, University of Bologna.

51. Achille Balduzzi, Geologist, Agip-Eni.

52. Claudio Borri, Professor of Construction Sciences, University of Florence, Coordinator of the International Doctorate in Engineering Civil.

53. Pino Cippitelli, Agip-Eni Geologist.

54. Franco Di Cesare, Executive, Agip-Eni.

55. Serena Doria, Researcher of Probability and Mathematical Statistics, University G. D’Annunzio, Chieti-Pescara.

56. Enzo Siviero, Professor of Ponti, University of Venice, Rector of the e-Campus University.

57. Pietro Agostini, Engineer, Association of Scientists and Tecnolgi for Italian Research.

58. Donato Barone, Engineer.

59. Roberto Bonucchi, Teacher.

60. Gianfranco Brignoli, Geologist.

61. Alessandro Chiaudani, Ph.D. agronomist, University G. D’Annunzio, Chieti-Pescara.

62. Antonio Clemente, Researcher in Urban Planning, University G. D’Annunzio, Chieti-Pescara.

63. Luigi Fressoia, urban architect, Perugia.

64. Sabino Gallo, nuclear engineer.

65. Daniela Giannessi, First Researcher, Ipcf-Cnr, Pisa.

66. Roberto Grassi, Engineer, Director of G&G, Rome.

67. Alberto Lagi, Engineer, President of Restoration of Complex Damaged Plants.

68. Luciano Lepori, Ipcf-Cnr Researcher, Pisa.

69. Roberto Madrigali, Metereologo.

70. Ludovica Manusardi, Nuclear physicist and scientific journalist, Ugis.

71. Maria Massullo, Technologist, Enea-Casaccia, Rome.

72. Enrico Matteoli, First Researcher, Ipcf-Cnr, Pisa.

73. Gabriella Mincione, Professor of Sciences and Techniques of Laboratory Medicine, University G. D’Annunzio, Chieti-Pescara.

74. Massimo Pallotta, First Technologist, National Institute for Nuclear Physics.

75. Enzo Pennetta, Professor of Natural Sciences and scientific divulger.

76. Nunzia Radatti, Chemist, Sogin.

77. Vincenzo Romanello, Nuclear Engineer, Research Center, Rez, Czech Republic.

78. Alberto Rota, Engineer, Researcher at Cise and Enel.

79. Massimo Sepielli, Director of Research, Enea, Rome.

80. Ugo Spezia, Engineer, Industrial Safety Manager, Sogin; Galileo Movement 2001.

81. Emilio Stefani, Professor of Plant Pathology, University of Modena.

82. Umberto Tirelli, Visiting Senior Scientist, Istituto Tumori d’Aviano; Galileo Movement 2001.

83. Roberto Vacca, Engineer and scientific writer.

—————-

Italienisches Original hier

Englische Übersetzung hier

Der Beitrag erschien zuerst bei „Die kalte Sonne“

Väter und Profiteure von „Klimaschutz“: Die Industrie ist die Zielscheibevon H.j. Lüdecke |

Von Andrea Andromidas

Die eigentlichen treibenden Kräfte hinter der Kampagne zur Reduzierung des Kohlenstoffs findet man nicht in den Bioläden, sondern an den Börsen. Früher wurde Energiepolitik zumindest in Deutschland entlang folgender Leitlinien formuliert: Versorgungssicherheit, Wirtschaftlichkeit und Umweltverträglichkeit. Politiker orientierten sich an den Vorgaben von Energiefachleuten und Machbarkeitsstudien, mit dem Ziel, dem wirtschaftlichen Aufbau zu dienen.

Seit das zweckdienliche Gespenst einer Klimakatastrophe durch die Medien geistert, hören sich die Vorgaben für den normalen Verstand sehr merkwürdig an: „Dekarbonisierung der Wirtschaft bis 2050“, „Der kommende entkarbonisierte Wohlstand“ oder „Die Vision eines entmaterialisierten Wachstums“. Auch der Gegenstand dieses Aufsatzes liegt für jeden normalen Bürger zunächst völlig im (noch dazu englischen) Nebel: „Carbon Disclosure Project“ was so viel heißt wie: Kohlenstoff-Offenlegungs-Projekt (zur vorgeblichen Erreichung irrationaler Klimaschutzziele). Da fragt man sich: Wer gibt hier den Ton an – und mit welchem wirklichen Ziel?